diff --git a/Deep Learning/README.md b/Deep Learning/README.md

index 2a9d4b4..758b8e9 100644

--- a/Deep Learning/README.md

+++ b/Deep Learning/README.md

@@ -16,6 +16,5 @@

| 深度学习 | [15. 深度学习的优化方法](https://github.com/NLP-LOVE/ML-NLP/tree/master/Deep%20Learning/15.%20DL%20Optimizer) | [@mantchs](https://github.com/NLP-LOVE) | 448966528 |

-> 欢迎大家加入!共同完善此项目!NLP学习QQ2群【207576902】 -

+> 欢迎大家加入!共同完善此项目!

-

+> 欢迎大家加入!共同完善此项目! diff --git a/Machine Learning/3.2 GBDT/3.2 GBDT.md b/Machine Learning/3.2 GBDT/3.2 GBDT.md

index 41d75f5..ffccaaa 100644

--- a/Machine Learning/3.2 GBDT/3.2 GBDT.md

+++ b/Machine Learning/3.2 GBDT/3.2 GBDT.md

@@ -81,7 +81,7 @@ GBDT的原理很简单,就是所有弱分类器的结果相加等于预测值

1. 预测阶段的计算速度快,树与树之间可并行化计算。

2. 在分布稠密的数据集上,泛化能力和表达能力都很好,这使得GBDT在Kaggle的众多竞赛中,经常名列榜首。

-3. 采用决策树作为弱分类器使得GBDT模型具有较好的解释性和鲁棒性,能够自动发现特征间的高阶关系。

+3. 采用决策树作为弱分类器使得GBDT模型具有较好的解释性和鲁棒性,能够自动发现特征间的高阶关系,并且也不需要对数据进行特殊的预处理如归一化等。

### 3.2 局限性

@@ -93,11 +93,11 @@ GBDT的原理很简单,就是所有弱分类器的结果相加等于预测值

**相同点**:

-- 都是由多棵树组成,最终的结果都是由多棵树一起决定。

-- RF和GBDT在使用CART树时,可以是分类树或者回归树。

+都是由多棵树组成,最终的结果都是由多棵树一起决定。

**不同点**:

+- 组成随机森林的树可以分类树也可以是回归树,而GBDT只由回归树组成

- 组成随机森林的树可以并行生成,而GBDT是串行生成

- 随机森林的结果是多数表决表决的,而GBDT则是多棵树累加之和

- 随机森林对异常值不敏感,而GBDT对异常值比较敏感

diff --git a/Machine Learning/9. KNN/README.md b/Machine Learning/9. KNN/README.md

index 9ae0dc8..13d65e0 100644

--- a/Machine Learning/9. KNN/README.md

+++ b/Machine Learning/9. KNN/README.md

@@ -77,7 +77,7 @@

=max_i(|p_i-q_i|))

- 这也等于以下Lp度量的极值: ,因此切比雪夫距离也称为L∞度量。

+ 这也等于以下Lp度量的极值: ^{1/k}),因此切比雪夫距离也称为L∞度量。

以数学的观点来看,切比雪夫距离是由一致范数(uniform norm)(或称为上确界范数)所衍生的度量,也是超凸度量(injective metric space)的一种。

diff --git a/Machine Learning/README.md b/Machine Learning/README.md

index 24cd0c9..c8a01f3 100644

--- a/Machine Learning/README.md

+++ b/Machine Learning/README.md

@@ -25,5 +25,4 @@

-> 欢迎大家加入!共同完善此项目!NLP学习QQ2群【207576902】

diff --git a/Machine Learning/3.2 GBDT/3.2 GBDT.md b/Machine Learning/3.2 GBDT/3.2 GBDT.md

index 41d75f5..ffccaaa 100644

--- a/Machine Learning/3.2 GBDT/3.2 GBDT.md

+++ b/Machine Learning/3.2 GBDT/3.2 GBDT.md

@@ -81,7 +81,7 @@ GBDT的原理很简单,就是所有弱分类器的结果相加等于预测值

1. 预测阶段的计算速度快,树与树之间可并行化计算。

2. 在分布稠密的数据集上,泛化能力和表达能力都很好,这使得GBDT在Kaggle的众多竞赛中,经常名列榜首。

-3. 采用决策树作为弱分类器使得GBDT模型具有较好的解释性和鲁棒性,能够自动发现特征间的高阶关系。

+3. 采用决策树作为弱分类器使得GBDT模型具有较好的解释性和鲁棒性,能够自动发现特征间的高阶关系,并且也不需要对数据进行特殊的预处理如归一化等。

### 3.2 局限性

@@ -93,11 +93,11 @@ GBDT的原理很简单,就是所有弱分类器的结果相加等于预测值

**相同点**:

-- 都是由多棵树组成,最终的结果都是由多棵树一起决定。

-- RF和GBDT在使用CART树时,可以是分类树或者回归树。

+都是由多棵树组成,最终的结果都是由多棵树一起决定。

**不同点**:

+- 组成随机森林的树可以分类树也可以是回归树,而GBDT只由回归树组成

- 组成随机森林的树可以并行生成,而GBDT是串行生成

- 随机森林的结果是多数表决表决的,而GBDT则是多棵树累加之和

- 随机森林对异常值不敏感,而GBDT对异常值比较敏感

diff --git a/Machine Learning/9. KNN/README.md b/Machine Learning/9. KNN/README.md

index 9ae0dc8..13d65e0 100644

--- a/Machine Learning/9. KNN/README.md

+++ b/Machine Learning/9. KNN/README.md

@@ -77,7 +77,7 @@

=max_i(|p_i-q_i|))

- 这也等于以下Lp度量的极值: ,因此切比雪夫距离也称为L∞度量。

+ 这也等于以下Lp度量的极值: ^{1/k}),因此切比雪夫距离也称为L∞度量。

以数学的观点来看,切比雪夫距离是由一致范数(uniform norm)(或称为上确界范数)所衍生的度量,也是超凸度量(injective metric space)的一种。

diff --git a/Machine Learning/README.md b/Machine Learning/README.md

index 24cd0c9..c8a01f3 100644

--- a/Machine Learning/README.md

+++ b/Machine Learning/README.md

@@ -25,5 +25,4 @@

-> 欢迎大家加入!共同完善此项目!NLP学习QQ2群【207576902】 -

+> 欢迎大家加入!共同完善此项目!

-

+> 欢迎大家加入!共同完善此项目! diff --git a/NLP/16.6 Attention/README.md b/NLP/16.6 Attention/README.md

index 80ae363..d7d0d37 100644

--- a/NLP/16.6 Attention/README.md

+++ b/NLP/16.6 Attention/README.md

@@ -1,16 +1,10 @@

## 目录

- [1. 什么是Attention机制](#1-什么是attention机制)

-- [2. 编解码器中的Attention](#2-编解码器中的attention)

- - [2.1 计算背景变量](#21-计算背景变量)

- - [2.2 更新隐藏状态](#22-更新隐藏状态)

-- [3. Attention本质](#3-attention本质)

- - [3.1 机器翻译说明Attention](#31-机器翻译说明attention)

- - [3.2 注意力分配概率计算](#32-注意力分配概率计算)

- - [3.3 Attention的物理含义](#33-attention的物理含义)

-- [4. Self-Attention模型](#4-self-attention模型)

-- [5. 发展](#5-发展)

-- [6. 代码实现](#6-代码实现)

-- [7. 参考文献](#7-参考文献)

+- [2. 计算背景变量](#2-计算背景变量)

+- [3. 更新隐藏状态](#3-更新隐藏状态)

+- [4. 发展](#4-发展)

+- [5. 代码实现](#5-代码实现)

+- [6. 参考文献](#6-参考文献)

## 1. 什么是Attention机制

@@ -28,9 +22,7 @@

-## 2. 编解码器中的Attention

-

-### 2.1 计算背景变量

+## 2. 计算背景变量

我们先描述第⼀个关键点,即计算背景变量。下图描绘了注意⼒机制如何为解码器在时间步 2 计算背景变量。

@@ -57,7 +49,7 @@

-### 2.2 更新隐藏状态

+## 3. 更新隐藏状态

现在我们描述第⼆个关键点,即更新隐藏状态。以⻔控循环单元为例,在解码器中我们可以对⻔控循环单元(GRU)中⻔控循环单元的设计稍作修改,从而变换上⼀时间步 t′−1 的输出 yt′−1、隐藏状态 st′−1 和当前时间步t′ 的含注意⼒机制的背景变量 ct′。解码器在时间步: math:t’ 的隐藏状态为:

@@ -71,89 +63,13 @@

-## 3. Attention本质

-

-### 3.1 机器翻译说明Attention

-

-本节先以机器翻译作为例子讲解最常见的Soft Attention模型的基本原理,之后抛离Encoder-Decoder框架抽象出了注意力机制的本质思想。

-

-如果拿机器翻译来解释这个Encoder-Decoder框架更好理解,比如输入的是英文句子:Tom chase Jerry,Encoder-Decoder框架逐步生成中文单词:“汤姆”,“追逐”,“杰瑞”。

-

-在翻译“杰瑞”这个中文单词的时候,模型里面的每个英文单词对于翻译目标单词“杰瑞”贡献是相同的,很明显这里不太合理,**显然“Jerry”对于翻译成“杰瑞”更重要,但是模型是无法体现这一点的,这就是为何说它没有引入注意力的原因。**

-

-没有引入注意力的模型在输入句子比较短的时候问题不大,但是如果输入句子比较长,此时所有语义完全通过一个中间语义向量来表示,单词自身的信息已经消失,可想而知会丢失很多细节信息,这也是为何要引入注意力模型的重要原因。

-

-上面的例子中,如果引入Attention模型的话,应该在翻译“杰瑞”的时候,体现出英文单词对于翻译当前中文单词不同的影响程度,比如给出类似下面一个概率分布值:

-

-(Tom,0.3)(Chase,0.2) (Jerry,0.5)

-

-**每个英文单词的概率代表了翻译当前单词“杰瑞”时,注意力分配模型分配给不同英文单词的注意力大小。**这对于正确翻译目标语单词肯定是有帮助的,因为引入了新的信息。

-

-同理,目标句子中的每个单词都应该学会其对应的源语句子中单词的注意力分配概率信息。这意味着在生成每个单词yi的时候,原先都是相同的中间语义表示C会被替换成根据当前生成单词而不断变化的Ci。理解Attention模型的关键就是这里,即由固定的中间语义表示C换成了根据当前输出单词来调整成加入注意力模型的变化的Ci。增加了注意力模型的Encoder-Decoder框架理解起来如下图所示。

-

-

-

-每个Ci可能对应着不同的源语句子单词的注意力分配概率分布,比如对于上面的英汉翻译来说,其对应的信息可能如下:

-

-

-

-其中,f2函数代表Encoder对输入英文单词的某种变换函数,比如如果Encoder是用的RNN模型的话,这个f2函数的结果往往是某个时刻输入xi后隐层节点的状态值;g代表Encoder根据单词的中间表示合成整个句子中间语义表示的变换函数,一般的做法中,g函数就是对构成元素加权求和,即下列公式:

-

-

-

-其中,Lx代表输入句子Source的长度,aij代表在Target输出第i个单词时Source输入句子中第j个单词的注意力分配系数,而hj则是Source输入句子中第j个单词的语义编码。假设下标i就是上面例子所说的“ 汤姆” ,那么Lx就是3,h1=f(“Tom”),h2=f(“Chase”),h3=f(“Jerry”)分别是输入句子每个单词的语义编码,对应的注意力模型权值则分别是0.6,0.2,0.2,所以g函数本质上就是个加权求和函数。

-

-

-

-### 3.2 注意力分配概率计算

-

-这里还有一个问题:生成目标句子某个单词,比如“汤姆”的时候,如何知道Attention模型所需要的输入句子单词注意力分配概率分布值呢?就是说“汤姆”对应的输入句子Source中各个单词的概率分布:(Tom,0.6)(Chase,0.2) (Jerry,0.2) 是如何得到的呢?

-

-对于采用RNN的Decoder来说,在时刻i,如果要生成yi单词,我们是可以知道Target在生成Yi之前的时刻i-1时,隐层节点i-1时刻的输出值Hi-1的,而我们的目的是要计算生成Yi时输入句子中的单词“Tom”、“Chase”、“Jerry”对Yi来说的注意力分配概率分布,那么可以用Target输出句子i-1时刻的隐层节点状态Hi-1去一一和输入句子Source中每个单词对应的RNN隐层节点状态hj进行对比,即通过函数F(hj,Hi-1)来获得目标单词yi和每个输入单词对应的对齐可能性,这个F函数在不同论文里可能会采取不同的方法,然后函数F的输出经过Softmax进行归一化就得到了符合概率分布取值区间的注意力分配概率分布数值。

-

-

-

-

-

-### 3.3 Attention的物理含义

-

-一般在自然语言处理应用里会把Attention模型看作是输出Target句子中某个单词和输入Source句子每个单词的对齐模型,这是非常有道理的。

-

-**目标句子生成的每个单词对应输入句子单词的概率分布可以理解为输入句子单词和这个目标生成单词的对齐概率,**这在机器翻译语境下是非常直观的:传统的统计机器翻译一般在做的过程中会专门有一个短语对齐的步骤,而注意力模型其实起的是相同的作用。

-

-如果把Attention机制从上文讲述例子中的Encoder-Decoder框架中剥离,并进一步做抽象,可以更容易看懂Attention机制的本质思想。

-

-

-

-我们可以这样来看待Attention机制(参考图9):将Source中的构成元素想象成是由一系列的数据对构成,此时给定Target中的某个元素Query,通过计算Query和各个Key的相似性或者相关性,得到每个Key对应Value的权重系数,然后对Value进行加权求和,即得到了最终的Attention数值。所以本质上Attention机制是对Source中元素的Value值进行加权求和,而Query和Key用来计算对应Value的权重系数。即可以将其本质思想改写为如下公式:

-

-=\sum_{i=1}^{L_x}Similarity(Query,key_i)*Value_i)

-

-其中,Lx=||Source||代表Source的长度,公式含义即如上所述。上文所举的机器翻译的例子里,因为在计算Attention的过程中,Source中的Key和Value合二为一,指向的是同一个东西,也即输入句子中每个单词对应的语义编码,所以可能不容易看出这种能够体现本质思想的结构。

-

-至于Attention机制的具体计算过程,如果对目前大多数方法进行抽象的话,可以将其归纳为两个过程:第一个过程是根据Query和Key计算权重系数,第二个过程根据权重系数对Value进行加权求和。而第一个过程又可以细分为两个阶段:第一个阶段根据Query和Key计算两者的相似性或者相关性;第二个阶段对第一阶段的原始分值进行归一化处理;

-

-

-

-## 4. Self-Attention模型

-

-Self Attention也经常被称为intra Attention(内部Attention),最近一年也获得了比较广泛的使用,比如Google最新的机器翻译模型内部大量采用了Self Attention模型。

-

-在一般任务的Encoder-Decoder框架中,输入Source和输出Target内容是不一样的,比如对于英-中机器翻译来说,Source是英文句子,Target是对应的翻译出的中文句子,Attention机制发生在Target的元素Query和Source中的所有元素之间。**而Self Attention顾名思义,指的不是Target和Source之间的Attention机制,而是Source内部元素之间或者Target内部元素之间发生的Attention机制,也可以理解为Target=Source这种特殊情况下的注意力计算机制。**其具体计算过程是一样的,只是计算对象发生了变化而已,所以此处不再赘述其计算过程细节。

-

-很明显,引入Self Attention后会更容易捕获句子中长距离的相互依赖的特征,因为如果是RNN或者LSTM,需要依次序序列计算,对于远距离的相互依赖的特征,要经过若干时间步步骤的信息累积才能将两者联系起来,而距离越远,有效捕获的可能性越小。

-

-但是Self Attention在计算过程中会直接将句子中任意两个单词的联系通过一个计算步骤直接联系起来,所以远距离依赖特征之间的距离被极大缩短,有利于有效地利用这些特征。除此外,Self Attention对于增加计算的并行性也有直接帮助作用。这是为何Self Attention逐渐被广泛使用的主要原因。

-

-

-

-## 5. 发展

+## 4. 发展

本质上,注意⼒机制能够为表征中较有价值的部分分配较多的计算资源。这个有趣的想法⾃提出后得到了快速发展,特别是启发了依靠注意⼒机制来编码输⼊序列并解码出输出序列的**变换器(Transformer)模型**的设计。变换器抛弃了卷积神经⽹络和循环神经⽹络的架构。它在计算效率上⽐基于循环神经⽹络的编码器—解码器模型通常更具明显优势。含注意⼒机制的变换器的编码结构在后来的**BERT预训练模型**中得以应⽤并令后者⼤放异彩:微调后的模型在多达11项⾃然语⾔处理任务中取得了当时最先进的结果。不久后,同样是基于变换器设计的**GPT-2模型**于新收集的语料数据集预训练后,在7个未参与训练的语⾔模型数据集上均取得了当时最先进的结果。除了⾃然语⾔处理领域,注意⼒机制还被⼴泛⽤于图像分类、⾃动图像描述、唇语解读以及语⾳识别。

-## 6. 代码实现

+## 5. 代码实现

**注意力模型实现中英文机器翻译**

@@ -167,12 +83,10 @@ Self Attention也经常被称为intra Attention(内部Attention),最近一

-## 7. 参考文献

+## 6. 参考文献

[动手学深度学习](https://www.lanzous.com/i5lqo4f)

-[注意力机制的基本思想和实现原理](https://blog.csdn.net/hpulfc/article/details/80448570)

-

------

diff --git a/NLP/16.7 Transformer/README.md b/NLP/16.7 Transformer/README.md

deleted file mode 100644

index bcd15c9..0000000

--- a/NLP/16.7 Transformer/README.md

+++ /dev/null

@@ -1,245 +0,0 @@

-## 目录

-- [1. 什么是Transformer](#1-什么是transformer)

-- [2. Transformer结构](#2-transformer结构)

- - [2.1 总体结构](#21-总体结构)

- - [2.2 Encoder层结构](#22-encoder层结构)

- - [2.3 Decoder层结构](#23-decoder层结构)

- - [2.4 动态流程图](#24-动态流程图)

-- [3. Transformer为什么需要进行Multi-head Attention](#3-transformer为什么需要进行multi-head-attention)

-- [4. Transformer相比于RNN/LSTM,有什么优势?为什么?](#4-transformer相比于rnnlstm有什么优势为什么)

-- [5. 为什么说Transformer可以代替seq2seq?](#5-为什么说transformer可以代替seq2seq)

-- [6. 代码实现](#6-代码实现)

-- [7. 参考文献](#7-参考文献)

-

-## 1. 什么是Transformer

-

-**[《Attention Is All You Need》](https://arxiv.org/pdf/1706.03762.pdf)是一篇Google提出的将Attention思想发挥到极致的论文。这篇论文中提出一个全新的模型,叫 Transformer,抛弃了以往深度学习任务里面使用到的 CNN 和 RNN**。目前大热的Bert就是基于Transformer构建的,这个模型广泛应用于NLP领域,例如机器翻译,问答系统,文本摘要和语音识别等等方向。

-

-

-

-## 2. Transformer结构

-

-### 2.1 总体结构

-

-Transformer的结构和Attention模型一样,Transformer模型中也采用了 encoer-decoder 架构。但其结构相比于Attention更加复杂,论文中encoder层由6个encoder堆叠在一起,decoder层也一样。

-

-不了解Attention模型的,可以回顾之前的文章:[Attention](https://github.com/NLP-LOVE/ML-NLP/tree/master/NLP/16.6%20Attention)

-

-

-

-每一个encoder和decoder的内部结构如下图:

-

-

-

-- encoder,包含两层,一个self-attention层和一个前馈神经网络,self-attention能帮助当前节点不仅仅只关注当前的词,从而能获取到上下文的语义。

-- decoder也包含encoder提到的两层网络,但是在这两层中间还有一层attention层,帮助当前节点获取到当前需要关注的重点内容。

-

-

-

-### 2.2 Encoder层结构

-

-首先,模型需要对输入的数据进行一个embedding操作,也可以理解为类似w2c的操作,enmbedding结束之后,输入到encoder层,self-attention处理完数据后把数据送给前馈神经网络,前馈神经网络的计算可以并行,得到的输出会输入到下一个encoder。

-

-

-

-

-

-#### 2.2.1 Positional Encoding

-

-transformer模型中缺少一种解释输入序列中单词顺序的方法,它跟序列模型还不不一样。为了处理这个问题,transformer给encoder层和decoder层的输入添加了一个额外的向量Positional Encoding,维度和embedding的维度一样,这个向量采用了一种很独特的方法来让模型学习到这个值,这个向量能决定当前词的位置,或者说在一个句子中不同的词之间的距离。这个位置向量的具体计算方法有很多种,论文中的计算方法如下:

-

-=sin(\frac{pos}{10000^{\frac{2i}{d_{model}}}}))

-

-=cos(\frac{pos}{10000^{\frac{2i}{d_{model}}}}))

-

-其中pos是指当前词在句子中的位置,i是指向量中每个值的index,可以看出,在**偶数位置,使用正弦编码,在奇数位置,使用余弦编码**。

-

-最后把这个Positional Encoding与embedding的值相加,作为输入送到下一层。

-

-

-

-

-

-#### 2.2.2 Self-Attention

-

-接下来我们详细看一下self-attention,其思想和attention类似,但是self-attention是Transformer用来将其他相关单词的“理解”转换成我们正在处理的单词的一种思路,我们看个例子:

-

-The animal didn't cross the street because it was too tired

-

-这里的 it 到底代表的是 animal 还是 street 呢,对于我们来说能很简单的判断出来,但是对于机器来说,是很难判断的,self-attention就能够让机器把 it 和 animal 联系起来,接下来我们看下详细的处理过程。

-

-1. 首先,self-attention会计算出三个新的向量,在论文中,向量的维度是512维,我们把这三个向量分别称为Query、Key、Value,这三个向量是用embedding向量与一个矩阵相乘得到的结果,这个矩阵是随机初始化的,维度为(64,512)注意第二个维度需要和embedding的维度一样,其值在BP的过程中会一直进行更新,得到的这三个向量的维度是64。

-

-

-

-2. 计算self-attention的分数值,该分数值决定了当我们在某个位置encode一个词时,对输入句子的其他部分的关注程度。这个分数值的计算方法是Query与Key做点成,以下图为例,首先我们需要针对Thinking这个词,计算出其他词对于该词的一个分数值,首先是针对于自己本身即q1·k1,然后是针对于第二个词即q1·k2。

-

-

-

-3. 接下来,把点成的结果除以一个常数,这里我们除以8,这个值一般是采用上文提到的矩阵的第一个维度的开方即64的开方8,当然也可以选择其他的值,然后把得到的结果做一个softmax的计算。得到的结果即是每个词对于当前位置的词的相关性大小,当然,当前位置的词相关性肯定会会很大。

-

-

-

-4. 下一步就是把Value和softmax得到的值进行相乘,并相加,得到的结果即是self-attetion在当前节点的值。

-

-

-

-在实际的应用场景,为了提高计算速度,我们采用的是矩阵的方式,直接计算出Query, Key, Value的矩阵,然后把embedding的值与三个矩阵直接相乘,把得到的新矩阵 Q 与 K 相乘,乘以一个常数,做softmax操作,最后乘上 V 矩阵。

-

-**这种通过 query 和 key 的相似性程度来确定 value 的权重分布的方法被称为scaled dot-product attention。**

-

-

-

-

-

-

-

-#### 2.2.3 Multi-Headed Attention

-

-这篇论文更牛逼的地方是给self-attention加入了另外一个机制,被称为“multi-headed” attention,该机制理解起来很简单,**就是说不仅仅只初始化一组Q、K、V的矩阵,而是初始化多组,tranformer是使用了8组**,所以最后得到的结果是8个矩阵。

-

-

-

-

-

-

-

-#### 2.2.4 Layer normalization

-

-在transformer中,每一个子层(self-attetion,Feed Forward Neural Network)之后都会接一个残缺模块,并且有一个Layer normalization。

-

-

-

-Normalization有很多种,但是它们都有一个共同的目的,那就是把输入转化成均值为0方差为1的数据。我们在把数据送入激活函数之前进行normalization(归一化),因为我们不希望输入数据落在激活函数的饱和区。

-

-**Batch Normalization**

-

-BN的主要思想就是:在每一层的每一批数据上进行归一化。我们可能会对输入数据进行归一化,但是经过该网络层的作用后,我们的数据已经不再是归一化的了。随着这种情况的发展,数据的偏差越来越大,我的反向传播需要考虑到这些大的偏差,这就迫使我们只能使用较小的学习率来防止梯度消失或者梯度爆炸。**BN的具体做法就是对每一小批数据,在批这个方向上做归一化。**

-

-**Layer normalization**

-

-它也是归一化数据的一种方式,不过**LN 是在每一个样本上计算均值和方差**,而不是BN那种在批方向计算均值和方差!公式如下:

-

-=\alpha*\frac{x_i-\mu_L}{\sqrt{\sigma_L^2+\varepsilon}}+\beta)

-

-

-

-

-

-#### 2.2.5 Feed Forward Neural Network

-

-这给我们留下了一个小的挑战,前馈神经网络没法输入 8 个矩阵呀,这该怎么办呢?所以我们需要一种方式,把 8 个矩阵降为 1 个,首先,我们把 8 个矩阵连在一起,这样会得到一个大的矩阵,再随机初始化一个矩阵和这个组合好的矩阵相乘,最后得到一个最终的矩阵。

-

-

-

-

-

-### 2.3 Decoder层结构

-

-根据上面的总体结构图可以看出,decoder部分其实和encoder部分大同小异,刚开始也是先添加一个位置向量Positional Encoding,方法和 2.2.1 节一样,接下来接的是masked mutil-head attetion,这里的mask也是transformer一个很关键的技术,下面我们会进行一一介绍。

-

-其余的层结构与Encoder一样,请参考Encoder层结构。

-

-

-

-#### 2.3.1 masked mutil-head attetion

-

-**mask 表示掩码,它对某些值进行掩盖,使其在参数更新时不产生效果**。Transformer 模型里面涉及两种 mask,分别是 padding mask 和 sequence mask。其中,padding mask 在所有的 scaled dot-product attention 里面都需要用到,而 sequence mask 只有在 decoder 的 self-attention 里面用到。

-

-1. **padding mask**

-

- 什么是 padding mask 呢?因为每个批次输入序列长度是不一样的也就是说,我们要对输入序列进行对齐。具体来说,就是给在较短的序列后面填充 0。但是如果输入的序列太长,则是截取左边的内容,把多余的直接舍弃。因为这些填充的位置,其实是没什么意义的,所以我们的attention机制不应该把注意力放在这些位置上,所以我们需要进行一些处理。

-

- 具体的做法是,把这些位置的值加上一个非常大的负数(负无穷),这样的话,经过 softmax,这些位置的概率就会接近0!

-

- 而我们的 padding mask 实际上是一个张量,每个值都是一个Boolean,值为 false 的地方就是我们要进行处理的地方。

-

-2. **Sequence mask**

-

- 文章前面也提到,sequence mask 是为了使得 decoder 不能看见未来的信息。也就是对于一个序列,在 time_step 为 t 的时刻,我们的解码输出应该只能依赖于 t 时刻之前的输出,而不能依赖 t 之后的输出。因此我们需要想一个办法,把 t 之后的信息给隐藏起来。

-

- 那么具体怎么做呢?也很简单:**产生一个上三角矩阵,上三角的值全为0。把这个矩阵作用在每一个序列上,就可以达到我们的目的**。

-

-- 对于 decoder 的 self-attention,里面使用到的 scaled dot-product attention,同时需要padding mask 和 sequence mask 作为 attn_mask,具体实现就是两个mask相加作为attn_mask。

-- 其他情况,attn_mask 一律等于 padding mask。

-

-

-

-#### 2.3.2 Output层

-

-当decoder层全部执行完毕后,怎么把得到的向量映射为我们需要的词呢,很简单,只需要在结尾再添加一个全连接层和softmax层,假如我们的词典是1w个词,那最终softmax会输入1w个词的概率,概率值最大的对应的词就是我们最终的结果。

-

-

-

-### 2.4 动态流程图

-

-编码器通过处理输入序列开启工作。顶端编码器的输出之后会变转化为一个包含向量K(键向量)和V(值向量)的注意力向量集 ,**这是并行化操作**。这些向量将被每个解码器用于自身的“编码-解码注意力层”,而这些层可以帮助解码器关注输入序列哪些位置合适:

-

-

-

-在完成编码阶段后,则开始解码阶段。解码阶段的每个步骤都会输出一个输出序列(在这个例子里,是英语翻译的句子)的元素。

-

-接下来的步骤重复了这个过程,直到到达一个特殊的终止符号,它表示transformer的解码器已经完成了它的输出。每个步骤的输出在下一个时间步被提供给底端解码器,并且就像编码器之前做的那样,这些解码器会输出它们的解码结果 。

-

-[解码器动态图请点击](https://julyedu-img.oss-cn-beijing.aliyuncs.com/quesbase64156846899939997439.gif)

-

-

-

-## 3. Transformer为什么需要进行Multi-head Attention

-

-原论文中说到进行Multi-head Attention的原因是将模型分为多个头,形成多个子空间,可以让模型去关注不同方面的信息,最后再将各个方面的信息综合起来。其实直观上也可以想到,如果自己设计这样的一个模型,必然也不会只做一次attention,多次attention综合的结果至少能够起到增强模型的作用,也可以类比CNN中同时使用**多个卷积核**的作用,直观上讲,多头的注意力**有助于网络捕捉到更丰富的特征/信息**。

-

-

-

-## 4. Transformer相比于RNN/LSTM,有什么优势?为什么?

-

-1. RNN系列的模型,并行计算能力很差。RNN并行计算的问题就出在这里,因为 T 时刻的计算依赖 T-1 时刻的隐层计算结果,而 T-1 时刻的计算依赖 T-2 时刻的隐层计算结果,如此下去就形成了所谓的序列依赖关系。

-

-2. Transformer的特征抽取能力比RNN系列的模型要好。

-

- 具体实验对比可以参考:[放弃幻想,全面拥抱Transformer:自然语言处理三大特征抽取器(CNN/RNN/TF)比较](https://zhuanlan.zhihu.com/p/54743941)

-

- 但是值得注意的是,并不是说Transformer就能够完全替代RNN系列的模型了,任何模型都有其适用范围,同样的,RNN系列模型在很多任务上还是首选,熟悉各种模型的内部原理,知其然且知其所以然,才能遇到新任务时,快速分析这时候该用什么样的模型,该怎么做好。

-

-

-

-## 5. 为什么说Transformer可以代替seq2seq?

-

-**seq2seq缺点**:这里用代替这个词略显不妥当,seq2seq虽已老,但始终还是有其用武之地,seq2seq最大的问题在于**将Encoder端的所有信息压缩到一个固定长度的向量中**,并将其作为Decoder端首个隐藏状态的输入,来预测Decoder端第一个单词(token)的隐藏状态。在输入序列比较长的时候,这样做显然会损失Encoder端的很多信息,而且这样一股脑的把该固定向量送入Decoder端,Decoder端不能够关注到其想要关注的信息。

-

-**Transformer优点**:transformer不但对seq2seq模型这两点缺点有了实质性的改进(多头交互式attention模块),而且还引入了self-attention模块,让源序列和目标序列首先“自关联”起来,这样的话,源序列和目标序列自身的embedding表示所蕴含的信息更加丰富,而且后续的FFN层也增强了模型的表达能力,并且Transformer并行计算的能力是远远超过seq2seq系列的模型,因此我认为这是transformer优于seq2seq模型的地方。

-

-

-

-## 6. 代码实现

-

-地址:[https://github.com/Kyubyong/transformer](https://github.com/Kyubyong/transformer)

-

-代码解读:[Transformer解析与tensorflow代码解读](https://www.cnblogs.com/zhouxiaosong/p/11032431.html)

-

-

-

-## 7. 参考文献

-

-- [Transformer模型详解](https://blog.csdn.net/u012526436/article/details/86295971)

-- [图解Transformer(完整版)](https://blog.csdn.net/longxinchen_ml/article/details/86533005)

-- [关于Transformer的若干问题整理记录](https://www.nowcoder.com/discuss/258321)

-

-

-

-------

-

-> 作者:[@mantchs](https://github.com/NLP-LOVE/ML-NLP)

->

-> GitHub:[https://github.com/NLP-LOVE/ML-NLP](https://github.com/NLP-LOVE/ML-NLP)

->

-> 欢迎大家加入讨论!共同完善此项目!群号:【541954936】

diff --git a/NLP/16.6 Attention/README.md b/NLP/16.6 Attention/README.md

index 80ae363..d7d0d37 100644

--- a/NLP/16.6 Attention/README.md

+++ b/NLP/16.6 Attention/README.md

@@ -1,16 +1,10 @@

## 目录

- [1. 什么是Attention机制](#1-什么是attention机制)

-- [2. 编解码器中的Attention](#2-编解码器中的attention)

- - [2.1 计算背景变量](#21-计算背景变量)

- - [2.2 更新隐藏状态](#22-更新隐藏状态)

-- [3. Attention本质](#3-attention本质)

- - [3.1 机器翻译说明Attention](#31-机器翻译说明attention)

- - [3.2 注意力分配概率计算](#32-注意力分配概率计算)

- - [3.3 Attention的物理含义](#33-attention的物理含义)

-- [4. Self-Attention模型](#4-self-attention模型)

-- [5. 发展](#5-发展)

-- [6. 代码实现](#6-代码实现)

-- [7. 参考文献](#7-参考文献)

+- [2. 计算背景变量](#2-计算背景变量)

+- [3. 更新隐藏状态](#3-更新隐藏状态)

+- [4. 发展](#4-发展)

+- [5. 代码实现](#5-代码实现)

+- [6. 参考文献](#6-参考文献)

## 1. 什么是Attention机制

@@ -28,9 +22,7 @@

-## 2. 编解码器中的Attention

-

-### 2.1 计算背景变量

+## 2. 计算背景变量

我们先描述第⼀个关键点,即计算背景变量。下图描绘了注意⼒机制如何为解码器在时间步 2 计算背景变量。

@@ -57,7 +49,7 @@

-### 2.2 更新隐藏状态

+## 3. 更新隐藏状态

现在我们描述第⼆个关键点,即更新隐藏状态。以⻔控循环单元为例,在解码器中我们可以对⻔控循环单元(GRU)中⻔控循环单元的设计稍作修改,从而变换上⼀时间步 t′−1 的输出 yt′−1、隐藏状态 st′−1 和当前时间步t′ 的含注意⼒机制的背景变量 ct′。解码器在时间步: math:t’ 的隐藏状态为:

@@ -71,89 +63,13 @@

-## 3. Attention本质

-

-### 3.1 机器翻译说明Attention

-

-本节先以机器翻译作为例子讲解最常见的Soft Attention模型的基本原理,之后抛离Encoder-Decoder框架抽象出了注意力机制的本质思想。

-

-如果拿机器翻译来解释这个Encoder-Decoder框架更好理解,比如输入的是英文句子:Tom chase Jerry,Encoder-Decoder框架逐步生成中文单词:“汤姆”,“追逐”,“杰瑞”。

-

-在翻译“杰瑞”这个中文单词的时候,模型里面的每个英文单词对于翻译目标单词“杰瑞”贡献是相同的,很明显这里不太合理,**显然“Jerry”对于翻译成“杰瑞”更重要,但是模型是无法体现这一点的,这就是为何说它没有引入注意力的原因。**

-

-没有引入注意力的模型在输入句子比较短的时候问题不大,但是如果输入句子比较长,此时所有语义完全通过一个中间语义向量来表示,单词自身的信息已经消失,可想而知会丢失很多细节信息,这也是为何要引入注意力模型的重要原因。

-

-上面的例子中,如果引入Attention模型的话,应该在翻译“杰瑞”的时候,体现出英文单词对于翻译当前中文单词不同的影响程度,比如给出类似下面一个概率分布值:

-

-(Tom,0.3)(Chase,0.2) (Jerry,0.5)

-

-**每个英文单词的概率代表了翻译当前单词“杰瑞”时,注意力分配模型分配给不同英文单词的注意力大小。**这对于正确翻译目标语单词肯定是有帮助的,因为引入了新的信息。

-

-同理,目标句子中的每个单词都应该学会其对应的源语句子中单词的注意力分配概率信息。这意味着在生成每个单词yi的时候,原先都是相同的中间语义表示C会被替换成根据当前生成单词而不断变化的Ci。理解Attention模型的关键就是这里,即由固定的中间语义表示C换成了根据当前输出单词来调整成加入注意力模型的变化的Ci。增加了注意力模型的Encoder-Decoder框架理解起来如下图所示。

-

-

-

-每个Ci可能对应着不同的源语句子单词的注意力分配概率分布,比如对于上面的英汉翻译来说,其对应的信息可能如下:

-

-

-

-其中,f2函数代表Encoder对输入英文单词的某种变换函数,比如如果Encoder是用的RNN模型的话,这个f2函数的结果往往是某个时刻输入xi后隐层节点的状态值;g代表Encoder根据单词的中间表示合成整个句子中间语义表示的变换函数,一般的做法中,g函数就是对构成元素加权求和,即下列公式:

-

-

-

-其中,Lx代表输入句子Source的长度,aij代表在Target输出第i个单词时Source输入句子中第j个单词的注意力分配系数,而hj则是Source输入句子中第j个单词的语义编码。假设下标i就是上面例子所说的“ 汤姆” ,那么Lx就是3,h1=f(“Tom”),h2=f(“Chase”),h3=f(“Jerry”)分别是输入句子每个单词的语义编码,对应的注意力模型权值则分别是0.6,0.2,0.2,所以g函数本质上就是个加权求和函数。

-

-

-

-### 3.2 注意力分配概率计算

-

-这里还有一个问题:生成目标句子某个单词,比如“汤姆”的时候,如何知道Attention模型所需要的输入句子单词注意力分配概率分布值呢?就是说“汤姆”对应的输入句子Source中各个单词的概率分布:(Tom,0.6)(Chase,0.2) (Jerry,0.2) 是如何得到的呢?

-

-对于采用RNN的Decoder来说,在时刻i,如果要生成yi单词,我们是可以知道Target在生成Yi之前的时刻i-1时,隐层节点i-1时刻的输出值Hi-1的,而我们的目的是要计算生成Yi时输入句子中的单词“Tom”、“Chase”、“Jerry”对Yi来说的注意力分配概率分布,那么可以用Target输出句子i-1时刻的隐层节点状态Hi-1去一一和输入句子Source中每个单词对应的RNN隐层节点状态hj进行对比,即通过函数F(hj,Hi-1)来获得目标单词yi和每个输入单词对应的对齐可能性,这个F函数在不同论文里可能会采取不同的方法,然后函数F的输出经过Softmax进行归一化就得到了符合概率分布取值区间的注意力分配概率分布数值。

-

-

-

-

-

-### 3.3 Attention的物理含义

-

-一般在自然语言处理应用里会把Attention模型看作是输出Target句子中某个单词和输入Source句子每个单词的对齐模型,这是非常有道理的。

-

-**目标句子生成的每个单词对应输入句子单词的概率分布可以理解为输入句子单词和这个目标生成单词的对齐概率,**这在机器翻译语境下是非常直观的:传统的统计机器翻译一般在做的过程中会专门有一个短语对齐的步骤,而注意力模型其实起的是相同的作用。

-

-如果把Attention机制从上文讲述例子中的Encoder-Decoder框架中剥离,并进一步做抽象,可以更容易看懂Attention机制的本质思想。

-

-

-

-我们可以这样来看待Attention机制(参考图9):将Source中的构成元素想象成是由一系列的数据对构成,此时给定Target中的某个元素Query,通过计算Query和各个Key的相似性或者相关性,得到每个Key对应Value的权重系数,然后对Value进行加权求和,即得到了最终的Attention数值。所以本质上Attention机制是对Source中元素的Value值进行加权求和,而Query和Key用来计算对应Value的权重系数。即可以将其本质思想改写为如下公式:

-

-=\sum_{i=1}^{L_x}Similarity(Query,key_i)*Value_i)

-

-其中,Lx=||Source||代表Source的长度,公式含义即如上所述。上文所举的机器翻译的例子里,因为在计算Attention的过程中,Source中的Key和Value合二为一,指向的是同一个东西,也即输入句子中每个单词对应的语义编码,所以可能不容易看出这种能够体现本质思想的结构。

-

-至于Attention机制的具体计算过程,如果对目前大多数方法进行抽象的话,可以将其归纳为两个过程:第一个过程是根据Query和Key计算权重系数,第二个过程根据权重系数对Value进行加权求和。而第一个过程又可以细分为两个阶段:第一个阶段根据Query和Key计算两者的相似性或者相关性;第二个阶段对第一阶段的原始分值进行归一化处理;

-

-

-

-## 4. Self-Attention模型

-

-Self Attention也经常被称为intra Attention(内部Attention),最近一年也获得了比较广泛的使用,比如Google最新的机器翻译模型内部大量采用了Self Attention模型。

-

-在一般任务的Encoder-Decoder框架中,输入Source和输出Target内容是不一样的,比如对于英-中机器翻译来说,Source是英文句子,Target是对应的翻译出的中文句子,Attention机制发生在Target的元素Query和Source中的所有元素之间。**而Self Attention顾名思义,指的不是Target和Source之间的Attention机制,而是Source内部元素之间或者Target内部元素之间发生的Attention机制,也可以理解为Target=Source这种特殊情况下的注意力计算机制。**其具体计算过程是一样的,只是计算对象发生了变化而已,所以此处不再赘述其计算过程细节。

-

-很明显,引入Self Attention后会更容易捕获句子中长距离的相互依赖的特征,因为如果是RNN或者LSTM,需要依次序序列计算,对于远距离的相互依赖的特征,要经过若干时间步步骤的信息累积才能将两者联系起来,而距离越远,有效捕获的可能性越小。

-

-但是Self Attention在计算过程中会直接将句子中任意两个单词的联系通过一个计算步骤直接联系起来,所以远距离依赖特征之间的距离被极大缩短,有利于有效地利用这些特征。除此外,Self Attention对于增加计算的并行性也有直接帮助作用。这是为何Self Attention逐渐被广泛使用的主要原因。

-

-

-

-## 5. 发展

+## 4. 发展

本质上,注意⼒机制能够为表征中较有价值的部分分配较多的计算资源。这个有趣的想法⾃提出后得到了快速发展,特别是启发了依靠注意⼒机制来编码输⼊序列并解码出输出序列的**变换器(Transformer)模型**的设计。变换器抛弃了卷积神经⽹络和循环神经⽹络的架构。它在计算效率上⽐基于循环神经⽹络的编码器—解码器模型通常更具明显优势。含注意⼒机制的变换器的编码结构在后来的**BERT预训练模型**中得以应⽤并令后者⼤放异彩:微调后的模型在多达11项⾃然语⾔处理任务中取得了当时最先进的结果。不久后,同样是基于变换器设计的**GPT-2模型**于新收集的语料数据集预训练后,在7个未参与训练的语⾔模型数据集上均取得了当时最先进的结果。除了⾃然语⾔处理领域,注意⼒机制还被⼴泛⽤于图像分类、⾃动图像描述、唇语解读以及语⾳识别。

-## 6. 代码实现

+## 5. 代码实现

**注意力模型实现中英文机器翻译**

@@ -167,12 +83,10 @@ Self Attention也经常被称为intra Attention(内部Attention),最近一

-## 7. 参考文献

+## 6. 参考文献

[动手学深度学习](https://www.lanzous.com/i5lqo4f)

-[注意力机制的基本思想和实现原理](https://blog.csdn.net/hpulfc/article/details/80448570)

-

------

diff --git a/NLP/16.7 Transformer/README.md b/NLP/16.7 Transformer/README.md

deleted file mode 100644

index bcd15c9..0000000

--- a/NLP/16.7 Transformer/README.md

+++ /dev/null

@@ -1,245 +0,0 @@

-## 目录

-- [1. 什么是Transformer](#1-什么是transformer)

-- [2. Transformer结构](#2-transformer结构)

- - [2.1 总体结构](#21-总体结构)

- - [2.2 Encoder层结构](#22-encoder层结构)

- - [2.3 Decoder层结构](#23-decoder层结构)

- - [2.4 动态流程图](#24-动态流程图)

-- [3. Transformer为什么需要进行Multi-head Attention](#3-transformer为什么需要进行multi-head-attention)

-- [4. Transformer相比于RNN/LSTM,有什么优势?为什么?](#4-transformer相比于rnnlstm有什么优势为什么)

-- [5. 为什么说Transformer可以代替seq2seq?](#5-为什么说transformer可以代替seq2seq)

-- [6. 代码实现](#6-代码实现)

-- [7. 参考文献](#7-参考文献)

-

-## 1. 什么是Transformer

-

-**[《Attention Is All You Need》](https://arxiv.org/pdf/1706.03762.pdf)是一篇Google提出的将Attention思想发挥到极致的论文。这篇论文中提出一个全新的模型,叫 Transformer,抛弃了以往深度学习任务里面使用到的 CNN 和 RNN**。目前大热的Bert就是基于Transformer构建的,这个模型广泛应用于NLP领域,例如机器翻译,问答系统,文本摘要和语音识别等等方向。

-

-

-

-## 2. Transformer结构

-

-### 2.1 总体结构

-

-Transformer的结构和Attention模型一样,Transformer模型中也采用了 encoer-decoder 架构。但其结构相比于Attention更加复杂,论文中encoder层由6个encoder堆叠在一起,decoder层也一样。

-

-不了解Attention模型的,可以回顾之前的文章:[Attention](https://github.com/NLP-LOVE/ML-NLP/tree/master/NLP/16.6%20Attention)

-

-

-

-每一个encoder和decoder的内部结构如下图:

-

-

-

-- encoder,包含两层,一个self-attention层和一个前馈神经网络,self-attention能帮助当前节点不仅仅只关注当前的词,从而能获取到上下文的语义。

-- decoder也包含encoder提到的两层网络,但是在这两层中间还有一层attention层,帮助当前节点获取到当前需要关注的重点内容。

-

-

-

-### 2.2 Encoder层结构

-

-首先,模型需要对输入的数据进行一个embedding操作,也可以理解为类似w2c的操作,enmbedding结束之后,输入到encoder层,self-attention处理完数据后把数据送给前馈神经网络,前馈神经网络的计算可以并行,得到的输出会输入到下一个encoder。

-

-

-

-

-

-#### 2.2.1 Positional Encoding

-

-transformer模型中缺少一种解释输入序列中单词顺序的方法,它跟序列模型还不不一样。为了处理这个问题,transformer给encoder层和decoder层的输入添加了一个额外的向量Positional Encoding,维度和embedding的维度一样,这个向量采用了一种很独特的方法来让模型学习到这个值,这个向量能决定当前词的位置,或者说在一个句子中不同的词之间的距离。这个位置向量的具体计算方法有很多种,论文中的计算方法如下:

-

-=sin(\frac{pos}{10000^{\frac{2i}{d_{model}}}}))

-

-=cos(\frac{pos}{10000^{\frac{2i}{d_{model}}}}))

-

-其中pos是指当前词在句子中的位置,i是指向量中每个值的index,可以看出,在**偶数位置,使用正弦编码,在奇数位置,使用余弦编码**。

-

-最后把这个Positional Encoding与embedding的值相加,作为输入送到下一层。

-

-

-

-

-

-#### 2.2.2 Self-Attention

-

-接下来我们详细看一下self-attention,其思想和attention类似,但是self-attention是Transformer用来将其他相关单词的“理解”转换成我们正在处理的单词的一种思路,我们看个例子:

-

-The animal didn't cross the street because it was too tired

-

-这里的 it 到底代表的是 animal 还是 street 呢,对于我们来说能很简单的判断出来,但是对于机器来说,是很难判断的,self-attention就能够让机器把 it 和 animal 联系起来,接下来我们看下详细的处理过程。

-

-1. 首先,self-attention会计算出三个新的向量,在论文中,向量的维度是512维,我们把这三个向量分别称为Query、Key、Value,这三个向量是用embedding向量与一个矩阵相乘得到的结果,这个矩阵是随机初始化的,维度为(64,512)注意第二个维度需要和embedding的维度一样,其值在BP的过程中会一直进行更新,得到的这三个向量的维度是64。

-

-

-

-2. 计算self-attention的分数值,该分数值决定了当我们在某个位置encode一个词时,对输入句子的其他部分的关注程度。这个分数值的计算方法是Query与Key做点成,以下图为例,首先我们需要针对Thinking这个词,计算出其他词对于该词的一个分数值,首先是针对于自己本身即q1·k1,然后是针对于第二个词即q1·k2。

-

-

-

-3. 接下来,把点成的结果除以一个常数,这里我们除以8,这个值一般是采用上文提到的矩阵的第一个维度的开方即64的开方8,当然也可以选择其他的值,然后把得到的结果做一个softmax的计算。得到的结果即是每个词对于当前位置的词的相关性大小,当然,当前位置的词相关性肯定会会很大。

-

-

-

-4. 下一步就是把Value和softmax得到的值进行相乘,并相加,得到的结果即是self-attetion在当前节点的值。

-

-

-

-在实际的应用场景,为了提高计算速度,我们采用的是矩阵的方式,直接计算出Query, Key, Value的矩阵,然后把embedding的值与三个矩阵直接相乘,把得到的新矩阵 Q 与 K 相乘,乘以一个常数,做softmax操作,最后乘上 V 矩阵。

-

-**这种通过 query 和 key 的相似性程度来确定 value 的权重分布的方法被称为scaled dot-product attention。**

-

-

-

-

-

-

-

-#### 2.2.3 Multi-Headed Attention

-

-这篇论文更牛逼的地方是给self-attention加入了另外一个机制,被称为“multi-headed” attention,该机制理解起来很简单,**就是说不仅仅只初始化一组Q、K、V的矩阵,而是初始化多组,tranformer是使用了8组**,所以最后得到的结果是8个矩阵。

-

-

-

-

-

-

-

-#### 2.2.4 Layer normalization

-

-在transformer中,每一个子层(self-attetion,Feed Forward Neural Network)之后都会接一个残缺模块,并且有一个Layer normalization。

-

-

-

-Normalization有很多种,但是它们都有一个共同的目的,那就是把输入转化成均值为0方差为1的数据。我们在把数据送入激活函数之前进行normalization(归一化),因为我们不希望输入数据落在激活函数的饱和区。

-

-**Batch Normalization**

-

-BN的主要思想就是:在每一层的每一批数据上进行归一化。我们可能会对输入数据进行归一化,但是经过该网络层的作用后,我们的数据已经不再是归一化的了。随着这种情况的发展,数据的偏差越来越大,我的反向传播需要考虑到这些大的偏差,这就迫使我们只能使用较小的学习率来防止梯度消失或者梯度爆炸。**BN的具体做法就是对每一小批数据,在批这个方向上做归一化。**

-

-**Layer normalization**

-

-它也是归一化数据的一种方式,不过**LN 是在每一个样本上计算均值和方差**,而不是BN那种在批方向计算均值和方差!公式如下:

-

-=\alpha*\frac{x_i-\mu_L}{\sqrt{\sigma_L^2+\varepsilon}}+\beta)

-

-

-

-

-

-#### 2.2.5 Feed Forward Neural Network

-

-这给我们留下了一个小的挑战,前馈神经网络没法输入 8 个矩阵呀,这该怎么办呢?所以我们需要一种方式,把 8 个矩阵降为 1 个,首先,我们把 8 个矩阵连在一起,这样会得到一个大的矩阵,再随机初始化一个矩阵和这个组合好的矩阵相乘,最后得到一个最终的矩阵。

-

-

-

-

-

-### 2.3 Decoder层结构

-

-根据上面的总体结构图可以看出,decoder部分其实和encoder部分大同小异,刚开始也是先添加一个位置向量Positional Encoding,方法和 2.2.1 节一样,接下来接的是masked mutil-head attetion,这里的mask也是transformer一个很关键的技术,下面我们会进行一一介绍。

-

-其余的层结构与Encoder一样,请参考Encoder层结构。

-

-

-

-#### 2.3.1 masked mutil-head attetion

-

-**mask 表示掩码,它对某些值进行掩盖,使其在参数更新时不产生效果**。Transformer 模型里面涉及两种 mask,分别是 padding mask 和 sequence mask。其中,padding mask 在所有的 scaled dot-product attention 里面都需要用到,而 sequence mask 只有在 decoder 的 self-attention 里面用到。

-

-1. **padding mask**

-

- 什么是 padding mask 呢?因为每个批次输入序列长度是不一样的也就是说,我们要对输入序列进行对齐。具体来说,就是给在较短的序列后面填充 0。但是如果输入的序列太长,则是截取左边的内容,把多余的直接舍弃。因为这些填充的位置,其实是没什么意义的,所以我们的attention机制不应该把注意力放在这些位置上,所以我们需要进行一些处理。

-

- 具体的做法是,把这些位置的值加上一个非常大的负数(负无穷),这样的话,经过 softmax,这些位置的概率就会接近0!

-

- 而我们的 padding mask 实际上是一个张量,每个值都是一个Boolean,值为 false 的地方就是我们要进行处理的地方。

-

-2. **Sequence mask**

-

- 文章前面也提到,sequence mask 是为了使得 decoder 不能看见未来的信息。也就是对于一个序列,在 time_step 为 t 的时刻,我们的解码输出应该只能依赖于 t 时刻之前的输出,而不能依赖 t 之后的输出。因此我们需要想一个办法,把 t 之后的信息给隐藏起来。

-

- 那么具体怎么做呢?也很简单:**产生一个上三角矩阵,上三角的值全为0。把这个矩阵作用在每一个序列上,就可以达到我们的目的**。

-

-- 对于 decoder 的 self-attention,里面使用到的 scaled dot-product attention,同时需要padding mask 和 sequence mask 作为 attn_mask,具体实现就是两个mask相加作为attn_mask。

-- 其他情况,attn_mask 一律等于 padding mask。

-

-

-

-#### 2.3.2 Output层

-

-当decoder层全部执行完毕后,怎么把得到的向量映射为我们需要的词呢,很简单,只需要在结尾再添加一个全连接层和softmax层,假如我们的词典是1w个词,那最终softmax会输入1w个词的概率,概率值最大的对应的词就是我们最终的结果。

-

-

-

-### 2.4 动态流程图

-

-编码器通过处理输入序列开启工作。顶端编码器的输出之后会变转化为一个包含向量K(键向量)和V(值向量)的注意力向量集 ,**这是并行化操作**。这些向量将被每个解码器用于自身的“编码-解码注意力层”,而这些层可以帮助解码器关注输入序列哪些位置合适:

-

-

-

-在完成编码阶段后,则开始解码阶段。解码阶段的每个步骤都会输出一个输出序列(在这个例子里,是英语翻译的句子)的元素。

-

-接下来的步骤重复了这个过程,直到到达一个特殊的终止符号,它表示transformer的解码器已经完成了它的输出。每个步骤的输出在下一个时间步被提供给底端解码器,并且就像编码器之前做的那样,这些解码器会输出它们的解码结果 。

-

-[解码器动态图请点击](https://julyedu-img.oss-cn-beijing.aliyuncs.com/quesbase64156846899939997439.gif)

-

-

-

-## 3. Transformer为什么需要进行Multi-head Attention

-

-原论文中说到进行Multi-head Attention的原因是将模型分为多个头,形成多个子空间,可以让模型去关注不同方面的信息,最后再将各个方面的信息综合起来。其实直观上也可以想到,如果自己设计这样的一个模型,必然也不会只做一次attention,多次attention综合的结果至少能够起到增强模型的作用,也可以类比CNN中同时使用**多个卷积核**的作用,直观上讲,多头的注意力**有助于网络捕捉到更丰富的特征/信息**。

-

-

-

-## 4. Transformer相比于RNN/LSTM,有什么优势?为什么?

-

-1. RNN系列的模型,并行计算能力很差。RNN并行计算的问题就出在这里,因为 T 时刻的计算依赖 T-1 时刻的隐层计算结果,而 T-1 时刻的计算依赖 T-2 时刻的隐层计算结果,如此下去就形成了所谓的序列依赖关系。

-

-2. Transformer的特征抽取能力比RNN系列的模型要好。

-

- 具体实验对比可以参考:[放弃幻想,全面拥抱Transformer:自然语言处理三大特征抽取器(CNN/RNN/TF)比较](https://zhuanlan.zhihu.com/p/54743941)

-

- 但是值得注意的是,并不是说Transformer就能够完全替代RNN系列的模型了,任何模型都有其适用范围,同样的,RNN系列模型在很多任务上还是首选,熟悉各种模型的内部原理,知其然且知其所以然,才能遇到新任务时,快速分析这时候该用什么样的模型,该怎么做好。

-

-

-

-## 5. 为什么说Transformer可以代替seq2seq?

-

-**seq2seq缺点**:这里用代替这个词略显不妥当,seq2seq虽已老,但始终还是有其用武之地,seq2seq最大的问题在于**将Encoder端的所有信息压缩到一个固定长度的向量中**,并将其作为Decoder端首个隐藏状态的输入,来预测Decoder端第一个单词(token)的隐藏状态。在输入序列比较长的时候,这样做显然会损失Encoder端的很多信息,而且这样一股脑的把该固定向量送入Decoder端,Decoder端不能够关注到其想要关注的信息。

-

-**Transformer优点**:transformer不但对seq2seq模型这两点缺点有了实质性的改进(多头交互式attention模块),而且还引入了self-attention模块,让源序列和目标序列首先“自关联”起来,这样的话,源序列和目标序列自身的embedding表示所蕴含的信息更加丰富,而且后续的FFN层也增强了模型的表达能力,并且Transformer并行计算的能力是远远超过seq2seq系列的模型,因此我认为这是transformer优于seq2seq模型的地方。

-

-

-

-## 6. 代码实现

-

-地址:[https://github.com/Kyubyong/transformer](https://github.com/Kyubyong/transformer)

-

-代码解读:[Transformer解析与tensorflow代码解读](https://www.cnblogs.com/zhouxiaosong/p/11032431.html)

-

-

-

-## 7. 参考文献

-

-- [Transformer模型详解](https://blog.csdn.net/u012526436/article/details/86295971)

-- [图解Transformer(完整版)](https://blog.csdn.net/longxinchen_ml/article/details/86533005)

-- [关于Transformer的若干问题整理记录](https://www.nowcoder.com/discuss/258321)

-

-

-

-------

-

-> 作者:[@mantchs](https://github.com/NLP-LOVE/ML-NLP)

->

-> GitHub:[https://github.com/NLP-LOVE/ML-NLP](https://github.com/NLP-LOVE/ML-NLP)

->

-> 欢迎大家加入讨论!共同完善此项目!群号:【541954936】 -

-

-

-

-

-

-

-

-

diff --git a/NLP/16.8 BERT/README.md b/NLP/16.8 BERT/README.md

deleted file mode 100644

index 77ab482..0000000

--- a/NLP/16.8 BERT/README.md

+++ /dev/null

@@ -1,241 +0,0 @@

-## 目录

-- [1. 什么是BERT](#1-什么是bert)

-- [2. 从Word Embedding到Bert模型的发展](#2-从word-embedding到bert模型的发展)

- - [2.1 图像的预训练](#21-图像的预训练)

- - [2.2 Word Embedding](#22-word-embedding)

- - [2.3 ELMO](#23-elmo)

- - [2.4 GPT](#24-gpt)

- - [2.5 BERT](#25-bert)

-- [3. BERT的评价](#3-bert的评价)

-- [4. 代码实现](#4-代码实现)

-- [5. 参考文献](#5-参考文献)

-

-## 1. 什么是BERT

-

-**BERT的全称是Bidirectional Encoder Representation from Transformers**,是Google2018年提出的预训练模型,即双向Transformer的Encoder,因为decoder是不能获要预测的信息的。模型的主要创新点都在pre-train方法上,即用了Masked LM和Next Sentence Prediction两种方法分别捕捉词语和句子级别的representation。

-

-Bert最近很火,应该是最近最火爆的AI进展,网上的评价很高,那么Bert值得这么高的评价吗?我个人判断是值得。那为什么会有这么高的评价呢?是因为它有重大的理论或者模型创新吗?其实并没有,从模型创新角度看一般,创新不算大。但是架不住效果太好了,基本刷新了很多NLP的任务的最好性能,有些任务还被刷爆了,这个才是关键。另外一点是Bert具备广泛的通用性,就是说绝大部分NLP任务都可以采用类似的两阶段模式直接去提升效果,这个第二关键。客观的说,把Bert当做最近两年NLP重大进展的集大成者更符合事实。

-

-

-

-## 2. 从Word Embedding到Bert模型的发展

-

-### 2.1 图像的预训练

-

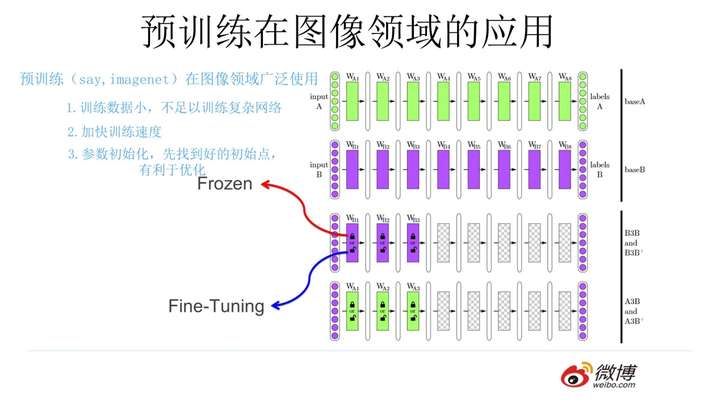

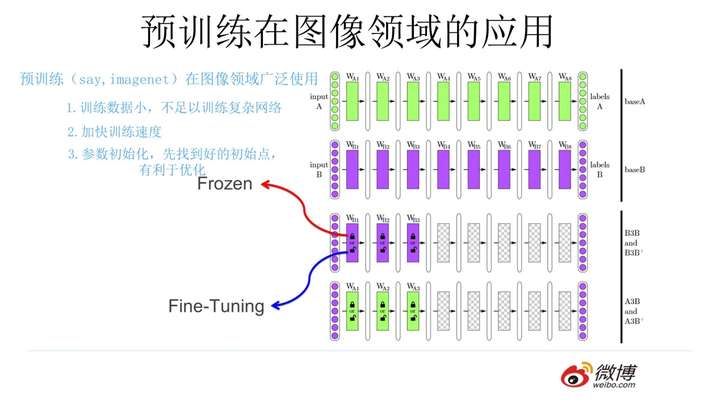

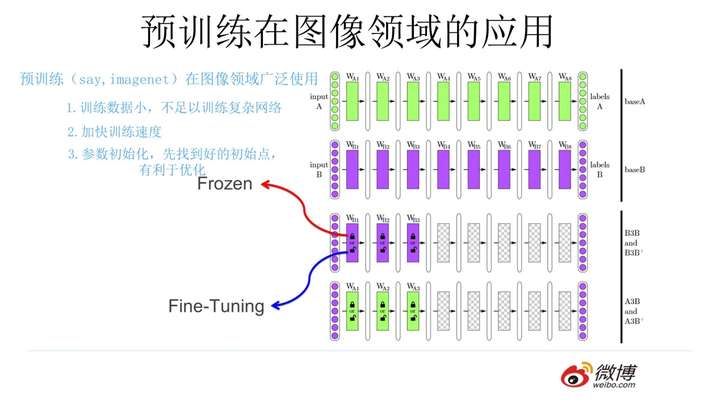

-自从深度学习火起来后,预训练过程就是做图像或者视频领域的一种比较常规的做法,有比较长的历史了,而且这种做法很有效,能明显促进应用的效果。

-

-

-

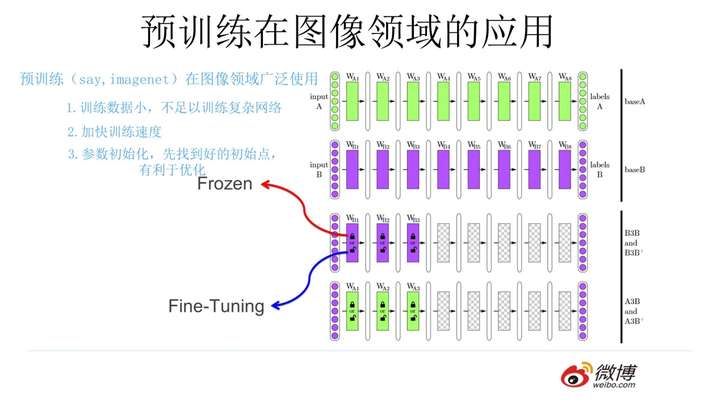

-那么图像领域怎么做预训练呢,上图展示了这个过程,

-

-1. 我们设计好网络结构以后,对于图像来说一般是CNN的多层叠加网络结构,可以先用某个训练集合比如训练集合A或者训练集合B对这个网络进行预先训练,在A任务上或者B任务上学会网络参数,然后存起来以备后用。

-

-2. 假设我们面临第三个任务C,网络结构采取相同的网络结构,在比较浅的几层CNN结构,网络参数初始化的时候可以加载A任务或者B任务学习好的参数,其它CNN高层参数仍然随机初始化。

-

-3. 之后我们用C任务的训练数据来训练网络,此时有两种做法:

-

- **一种**是浅层加载的参数在训练C任务过程中不动,这种方法被称为“Frozen”;

-

- **另一种**是底层网络参数尽管被初始化了,在C任务训练过程中仍然随着训练的进程不断改变,这种一般叫“Fine-Tuning”,顾名思义,就是更好地把参数进行调整使得更适应当前的C任务。

-

-一般图像或者视频领域要做预训练一般都这么做。这样做的优点是:如果手头任务C的训练集合数据量较少的话,利用预训练出来的参数来训练任务C,加个预训练过程也能极大加快任务训练的收敛速度,所以这种预训练方式是老少皆宜的解决方案,另外疗效又好,所以在做图像处理领域很快就流行开来。

-

-**为什么预训练可行**

-

-对于层级的CNN结构来说,不同层级的神经元学习到了不同类型的图像特征,由底向上特征形成层级结构,所以预训练好的网络参数,尤其是底层的网络参数抽取出特征跟具体任务越无关,越具备任务的通用性,所以这是为何一般用底层预训练好的参数初始化新任务网络参数的原因。而高层特征跟任务关联较大,实际可以不用使用,或者采用Fine-tuning用新数据集合清洗掉高层无关的特征抽取器。

-

-

-

-### 2.2 Word Embedding

-

-

-

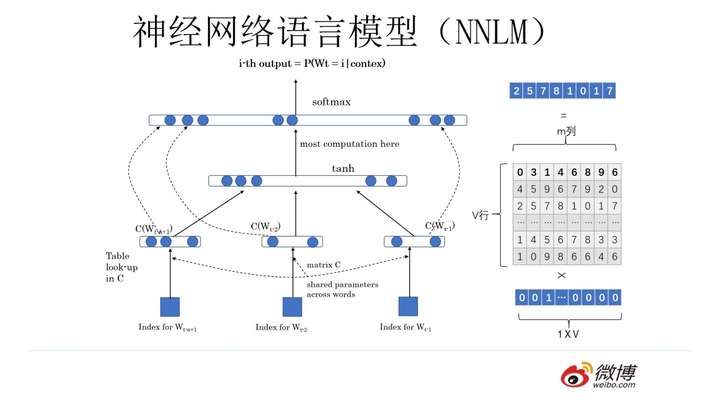

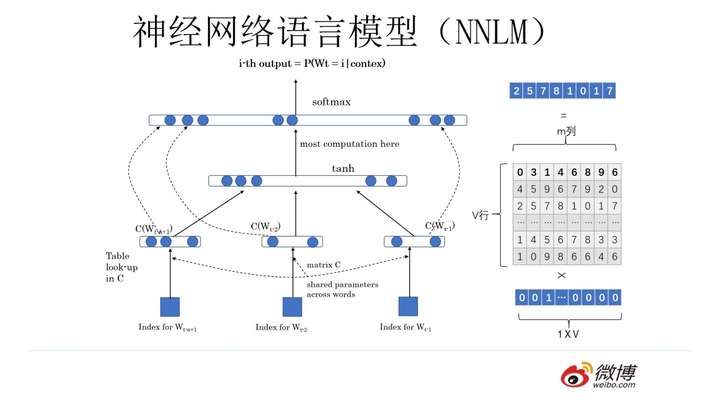

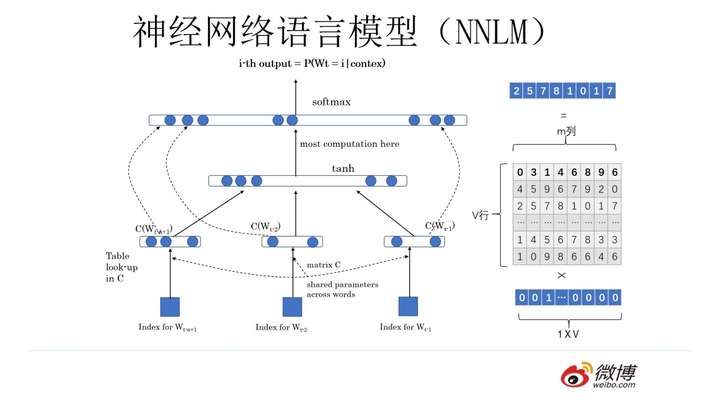

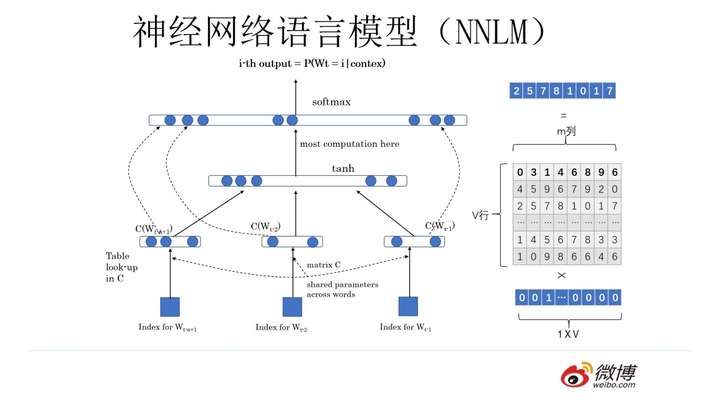

-神经网络语言模型(NNLM)的思路。先说训练过程。学习任务是输入某个句中单词 ![[公式]](https://www.zhihu.com/equation?tex=W_t=(Bert)) 前面句子的t-1个单词,要求网络正确预测单词Bert,即最大化:

-

-![[公式]](https://www.zhihu.com/equation?tex=++P%28W_t%3D%E2%80%9CBert%E2%80%9D%7CW_1%2CW_2%2C%E2%80%A6W_%28t-1%29%3B%CE%B8%29)

-

-前面任意单词 ![[公式]](https://www.zhihu.com/equation?tex=W_i) 用Onehot编码(比如:0001000)作为原始单词输入,之后乘以矩阵Q后获得向量 ![[公式]](https://www.zhihu.com/equation?tex=C%28W_i+%29) ,每个单词的 ![[公式]](https://www.zhihu.com/equation?tex=C%28W_i+%29) 拼接,上接隐层,然后接softmax去预测后面应该后续接哪个单词。这个 ![[公式]](https://www.zhihu.com/equation?tex=C%28W_i+%29) 是什么?这其实就是单词对应的Word Embedding值,那个矩阵Q包含V行,V代表词典大小,每一行内容代表对应单词的Word embedding值。只不过Q的内容也是网络参数,需要学习获得,训练刚开始用随机值初始化矩阵Q,当这个网络训练好之后,矩阵Q的内容被正确赋值,每一行代表一个单词对应的Word embedding值。所以你看,通过这个网络学习语言模型任务,这个网络不仅自己能够根据上文预测后接单词是什么,同时获得一个副产品,就是那个矩阵Q,这就是单词的Word Embedding。

-

-2013年最火的用语言模型做Word Embedding的工具是Word2Vec,后来又出了Glove,Word2Vec。对于这两个模型不熟悉的可以参考我之前的文章,这里不再赘述:

-

-- [Word2Vec](https://github.com/NLP-LOVE/ML-NLP/tree/master/NLP/16.1%20Word%20Embedding)

-- [GloVe](https://github.com/NLP-LOVE/ML-NLP/tree/master/NLP/16.3%20GloVe)

-

-上面这种模型做法就是18年之前NLP领域里面采用预训练的典型做法,之前说过,Word Embedding其实对于很多下游NLP任务是有帮助的,只是帮助没有大到闪瞎忘记戴墨镜的围观群众的双眼而已。那么新问题来了,为什么这样训练及使用Word Embedding的效果没有期待中那么好呢?答案很简单,因为Word Embedding有问题呗。这貌似是个比较弱智的答案,关键是Word Embedding存在什么问题?这其实是个好问题。

-

-**这片在Word Embedding头上笼罩了好几年的乌云是什么?是多义词问题。**我们知道,多义词是自然语言中经常出现的现象,也是语言灵活性和高效性的一种体现。多义词对Word Embedding来说有什么负面影响?如上图所示,比如多义词Bank,有两个常用含义,但是Word Embedding在对bank这个单词进行编码的时候,是区分不开这两个含义的,因为它们尽管上下文环境中出现的单词不同,但是在用语言模型训练的时候,不论什么上下文的句子经过word2vec,都是预测相同的单词bank,而同一个单词占的是同一行的参数空间,这导致两种不同的上下文信息都会编码到相同的word embedding空间里去。所以word embedding无法区分多义词的不同语义,这就是它的一个比较严重的问题。

-

-有没有简单优美的解决方案呢?ELMO提供了一种简洁优雅的解决方案。

-

-

-

-### 2.3 ELMO

-

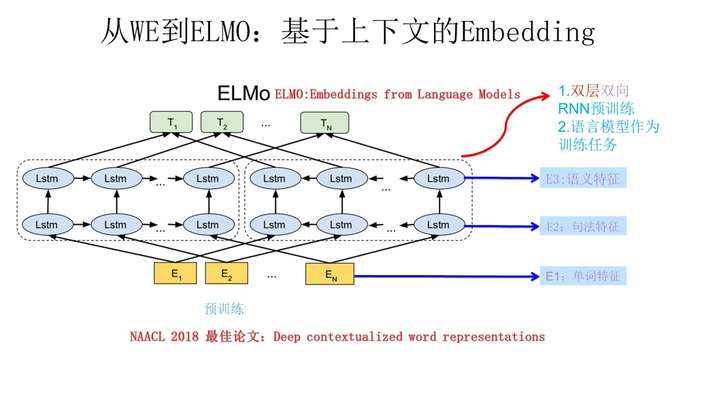

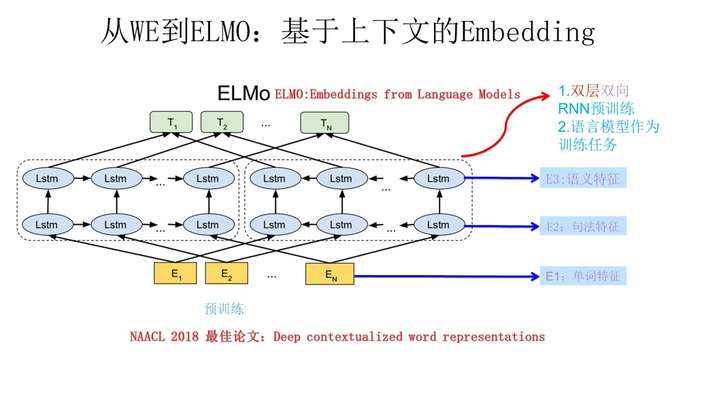

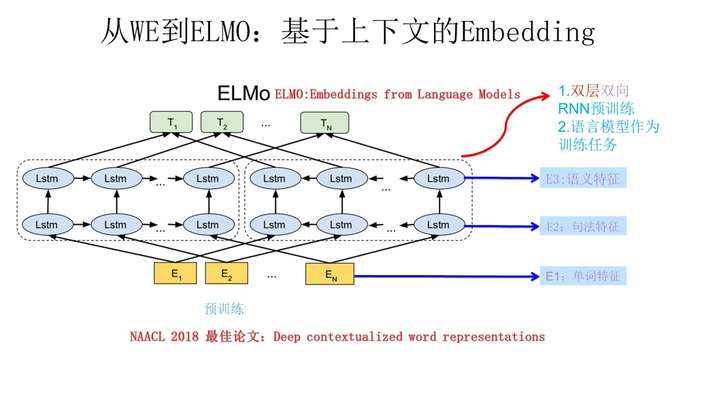

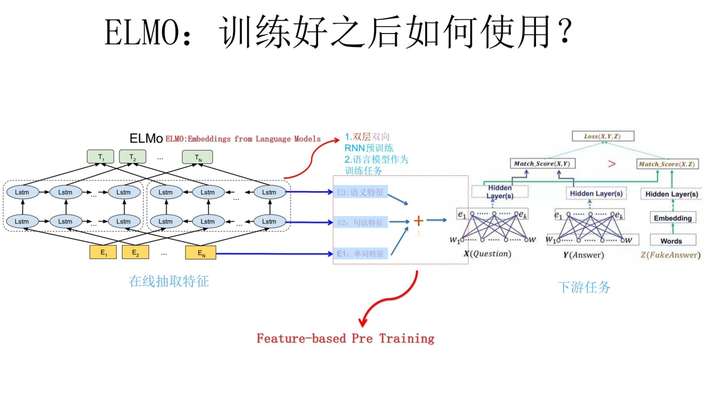

-ELMO是“Embedding from Language Models”的简称,其实这个名字并没有反应它的本质思想,提出ELMO的论文题目:“Deep contextualized word representation”更能体现其精髓,而精髓在哪里?在deep contextualized这个短语,一个是deep,一个是context,其中context更关键。

-

-在此之前的Word Embedding本质上是个静态的方式,所谓静态指的是训练好之后每个单词的表达就固定住了,以后使用的时候,不论新句子上下文单词是什么,这个单词的Word Embedding不会跟着上下文场景的变化而改变,所以对于比如Bank这个词,它事先学好的Word Embedding中混合了几种语义 ,在应用中来了个新句子,即使从上下文中(比如句子包含money等词)明显可以看出它代表的是“银行”的含义,但是对应的Word Embedding内容也不会变,它还是混合了多种语义。这是为何说它是静态的,这也是问题所在。

-

-**ELMO的本质思想是**:我事先用语言模型学好一个单词的Word Embedding,此时多义词无法区分,不过这没关系。在我实际使用Word Embedding的时候,单词已经具备了特定的上下文了,这个时候我可以根据上下文单词的语义去调整单词的Word Embedding表示,这样经过调整后的Word Embedding更能表达在这个上下文中的具体含义,自然也就解决了多义词的问题了。所以ELMO本身是个根据当前上下文对Word Embedding动态调整的思路。

-

-

-

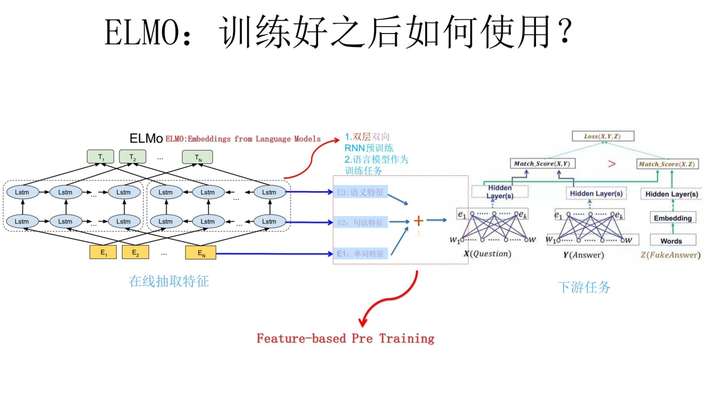

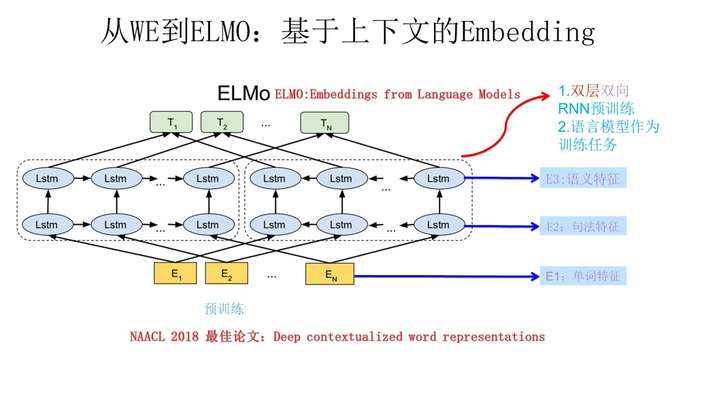

-ELMO采用了典型的两阶段过程,第一个阶段是利用语言模型进行预训练;第二个阶段是在做下游任务时,从预训练网络中提取对应单词的网络各层的Word Embedding作为新特征补充到下游任务中。

-

-上图展示的是其预训练过程,它的网络结构采用了双层双向LSTM,目前语言模型训练的任务目标是根据单词 ![[公式]](https://www.zhihu.com/equation?tex=W_i) 的上下文去正确预测单词 ![[公式]](https://www.zhihu.com/equation?tex=W_i) , ![[公式]](https://www.zhihu.com/equation?tex=W_i) 之前的单词序列Context-before称为上文,之后的单词序列Context-after称为下文。

-

-图中左端的前向双层LSTM代表正方向编码器,输入的是从左到右顺序的除了预测单词外 ![[公式]](https://www.zhihu.com/equation?tex=W_i) 的上文Context-before;右端的逆向双层LSTM代表反方向编码器,输入的是从右到左的逆序的句子下文Context-after;每个编码器的深度都是两层LSTM叠加。

-

-这个网络结构其实在NLP中是很常用的。使用这个网络结构利用大量语料做语言模型任务就能预先训练好这个网络,如果训练好这个网络后,输入一个新句子 ![[公式]](https://www.zhihu.com/equation?tex=Snew) ,句子中每个单词都能得到对应的三个Embedding:

-

-- 最底层是单词的Word Embedding;

-- 往上走是第一层双向LSTM中对应单词位置的Embedding,这层编码单词的句法信息更多一些;

-- 再往上走是第二层LSTM中对应单词位置的Embedding,这层编码单词的语义信息更多一些。

-

-也就是说,ELMO的预训练过程不仅仅学会单词的Word Embedding,还学会了一个双层双向的LSTM网络结构,而这两者后面都有用。

-

-

-

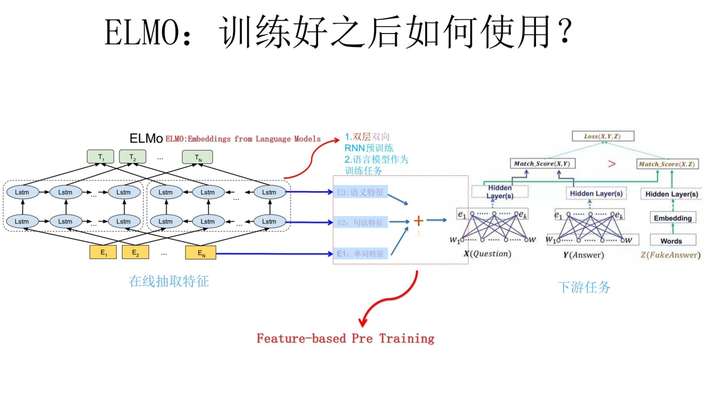

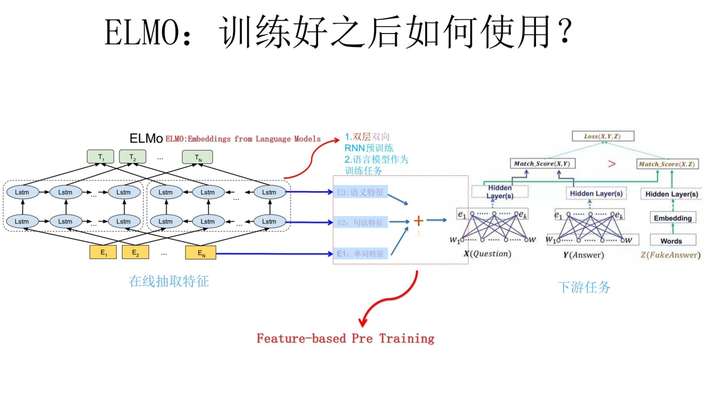

-上面介绍的是ELMO的第一阶段:预训练阶段。那么预训练好网络结构后,**如何给下游任务使用呢**?上图展示了下游任务的使用过程,比如我们的下游任务仍然是QA问题:

-

-1. 此时对于问句X,我们可以先将句子X作为预训练好的ELMO网络的输入,这样句子X中每个单词在ELMO网络中都能获得对应的三个Embedding;

-2. 之后给予这三个Embedding中的每一个Embedding一个权重a,这个权重可以学习得来,根据各自权重累加求和,将三个Embedding整合成一个;

-3. 然后将整合后的这个Embedding作为X句在自己任务的那个网络结构中对应单词的输入,以此作为补充的新特征给下游任务使用。对于上图所示下游任务QA中的回答句子Y来说也是如此处理。

-

-因为ELMO给下游提供的是每个单词的特征形式,所以这一类预训练的方法被称为“Feature-based Pre-Training”。

-

-**前面我们提到静态Word Embedding无法解决多义词的问题,那么ELMO引入上下文动态调整单词的embedding后多义词问题解决了吗?解决了,而且比我们期待的解决得还要好**。对于Glove训练出的Word Embedding来说,多义词比如play,根据它的embedding找出的最接近的其它单词大多数集中在体育领域,这很明显是因为训练数据中包含play的句子中体育领域的数量明显占优导致;而使用ELMO,根据上下文动态调整后的embedding不仅能够找出对应的“演出”的相同语义的句子,而且还可以保证找出的句子中的play对应的词性也是相同的,这是超出期待之处。之所以会这样,是因为我们上面提到过,第一层LSTM编码了很多句法信息,这在这里起到了重要作用。

-

-**ELMO有什么值得改进的缺点呢**?

-

-- 首先,一个非常明显的缺点在特征抽取器选择方面,ELMO使用了LSTM而不是新贵Transformer,Transformer是谷歌在17年做机器翻译任务的“Attention is all you need”的论文中提出的,引起了相当大的反响,很多研究已经证明了Transformer提取特征的能力是要远强于LSTM的。如果ELMO采取Transformer作为特征提取器,那么估计Bert的反响远不如现在的这种火爆场面。

-- 另外一点,ELMO采取双向拼接这种融合特征的能力可能比Bert一体化的融合特征方式弱,但是,这只是一种从道理推断产生的怀疑,目前并没有具体实验说明这一点。

-

-

-

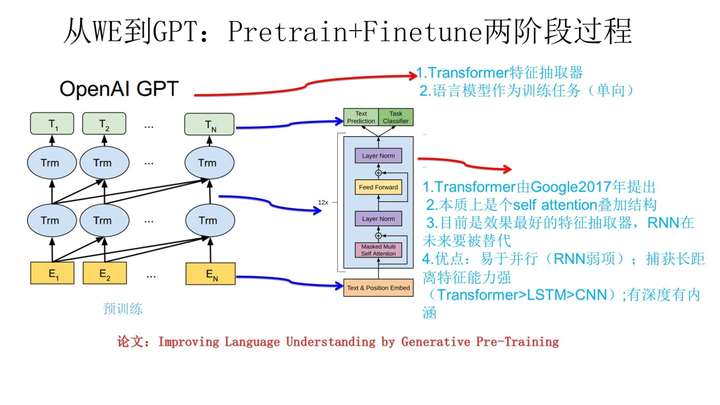

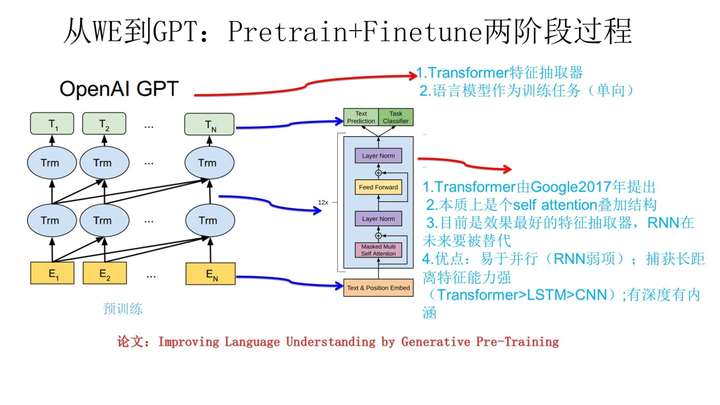

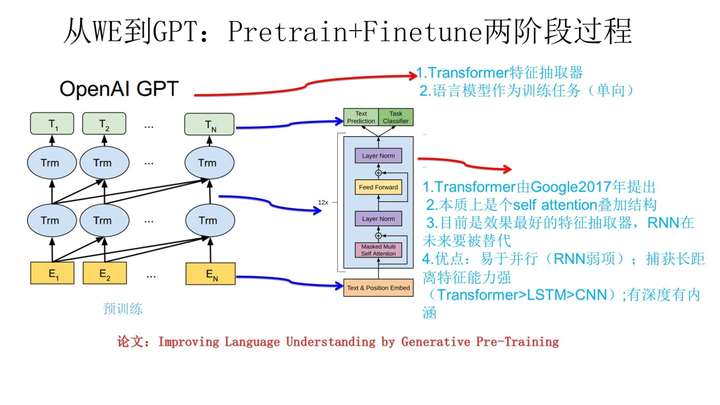

-### 2.4 GPT

-

-

-

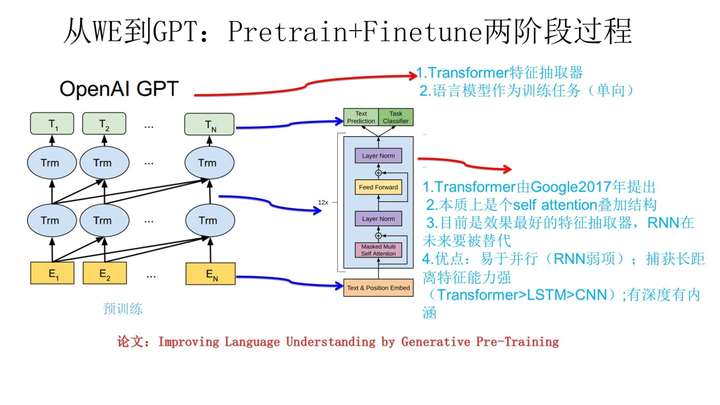

-GPT是“Generative Pre-Training”的简称,从名字看其含义是指的生成式的预训练。GPT也采用两阶段过程,第一个阶段是利用语言模型进行预训练,第二阶段通过Fine-tuning的模式解决下游任务。

-

-上图展示了GPT的预训练过程,其实和ELMO是类似的,主要不同在于两点:

-

-- 首先,特征抽取器不是用的RNN,而是用的Transformer,上面提到过它的特征抽取能力要强于RNN,这个选择很明显是很明智的;

-- 其次,GPT的预训练虽然仍然是以语言模型作为目标任务,但是采用的是单向的语言模型,所谓“单向”的含义是指:语言模型训练的任务目标是根据 ![[公式]](https://www.zhihu.com/equation?tex=W_i) 单词的上下文去正确预测单词 ![[公式]](https://www.zhihu.com/equation?tex=W_i) , ![[公式]](https://www.zhihu.com/equation?tex=W_i) 之前的单词序列Context-before称为上文,之后的单词序列Context-after称为下文。

-

-如果对Transformer模型不太了解的,可以参考我写的文章:[Transformer](https://github.com/NLP-LOVE/ML-NLP/tree/master/NLP/16.7%20Transformer)

-

-ELMO在做语言模型预训练的时候,预测单词 ![[公式]](https://www.zhihu.com/equation?tex=W_i) 同时使用了上文和下文,而GPT则只采用Context-before这个单词的上文来进行预测,而抛开了下文。这个选择现在看不是个太好的选择,原因很简单,它没有把单词的下文融合进来,这限制了其在更多应用场景的效果,比如阅读理解这种任务,在做任务的时候是可以允许同时看到上文和下文一起做决策的。如果预训练时候不把单词的下文嵌入到Word Embedding中,是很吃亏的,白白丢掉了很多信息。

-

-

-

-### 2.5 BERT

-

-Bert采用和GPT完全相同的两阶段模型,首先是语言模型预训练;其次是使用Fine-Tuning模式解决下游任务。和GPT的最主要不同在于在预训练阶段采用了类似ELMO的双向语言模型,即双向的Transformer,当然另外一点是语言模型的数据规模要比GPT大。所以这里Bert的预训练过程不必多讲了。模型结构如下:

-

-

-

-对比OpenAI GPT(Generative pre-trained transformer),BERT是双向的Transformer block连接;就像单向rnn和双向rnn的区别,直觉上来讲效果会好一些。

-

-对比ELMo,虽然都是“双向”,但目标函数其实是不同的。ELMo是分别以![[公式]](https://www.zhihu.com/equation?tex=P%28w_i%7C+w_1%2C+...w_%7Bi-1%7D%29) 和 ![[公式]](https://www.zhihu.com/equation?tex=P%28w_i%7Cw_%7Bi%2B1%7D%2C+...w_n%29) 作为目标函数,独立训练处两个representation然后拼接,而BERT则是以 ![[公式]](https://www.zhihu.com/equation?tex=P%28w_i%7Cw_1%2C++...%2Cw_%7Bi-1%7D%2C+w_%7Bi%2B1%7D%2C...%2Cw_n%29) 作为目标函数训练LM。

-

-BERT预训练模型分为以下三个步骤:**Embedding、Masked LM、Next Sentence Prediction**

-

-#### 2.5.1 Embedding

-

-这里的Embedding由三种Embedding求和而成:

-

-

-

-- Token Embeddings是词向量,第一个单词是CLS标志,可以用于之后的分类任务

-- Segment Embeddings用来区别两种句子,因为预训练不光做LM还要做以两个句子为输入的分类任务

-- Position Embeddings和之前文章中的Transformer不一样,不是三角函数而是学习出来的

-

-

-

-#### 2.5.2 Masked LM

-

-MLM可以理解为完形填空,作者会随机mask每一个句子中15%的词,用其上下文来做预测,例如:my dog is hairy → my dog is [MASK]

-

-此处将hairy进行了mask处理,然后采用非监督学习的方法预测mask位置的词是什么,但是该方法有一个问题,因为是mask15%的词,其数量已经很高了,这样就会导致某些词在fine-tuning阶段从未见过,为了解决这个问题,作者做了如下的处理:

-

-80%是采用[mask],my dog is hairy → my dog is [MASK]

-

-10%是随机取一个词来代替mask的词,my dog is hairy -> my dog is apple

-

-10%保持不变,my dog is hairy -> my dog is hairy

-

-**注意:这里的10%是15%需要mask中的10%**

-

-那么为啥要以一定的概率使用随机词呢?这是因为transformer要保持对每个输入token分布式的表征,否则Transformer很可能会记住这个[MASK]就是"hairy"。至于使用随机词带来的负面影响,文章中解释说,所有其他的token(即非"hairy"的token)共享15%*10% = 1.5%的概率,其影响是可以忽略不计的。Transformer全局的可视,又增加了信息的获取,但是不让模型获取全量信息。

-

-

-

-#### 2.5.3 Next Sentence Prediction

-

-选择一些句子对A与B,其中50%的数据B是A的下一条句子,剩余50%的数据B是语料库中随机选择的,学习其中的相关性,添加这样的预训练的目的是目前很多NLP的任务比如QA和NLI都需要理解两个句子之间的关系,从而能让预训练的模型更好的适应这样的任务。

-个人理解:

-

-- Bert先是用Mask来提高视野范围的信息获取量,增加duplicate再随机Mask,这样跟RNN类方法依次训练预测没什么区别了除了mask不同位置外;

-- 全局视野极大地降低了学习的难度,然后再用A+B/C来作为样本,这样每条样本都有50%的概率看到一半左右的噪声;

-- 但直接学习Mask A+B/C是没法学习的,因为不知道哪些是噪声,所以又加上next_sentence预测任务,与MLM同时进行训练,这样用next来辅助模型对噪声/非噪声的辨识,用MLM来完成语义的大部分的学习。

-

-

-

-## 3. BERT的评价

-

-总结下BERT的主要贡献:

-

-- 引入了Masked LM,使用双向LM做模型预训练。

-- 为预训练引入了新目标NSP,它可以学习句子与句子间的关系。

-- 进一步验证了更大的模型效果更好: 12 --> 24 层。

-- 为下游任务引入了很通用的求解框架,不再为任务做模型定制。

-- 刷新了多项NLP任务的记录,引爆了NLP无监督预训练技术。

-

-**BERT优点**

-

-- Transformer Encoder因为有Self-attention机制,因此BERT自带双向功能。

-- 因为双向功能以及多层Self-attention机制的影响,使得BERT必须使用Cloze版的语言模型Masked-LM来完成token级别的预训练。

-- 为了获取比词更高级别的句子级别的语义表征,BERT加入了Next Sentence Prediction来和Masked-LM一起做联合训练。

-- 为了适配多任务下的迁移学习,BERT设计了更通用的输入层和输出层。

-- 微调成本小。

-

-**BERT缺点**

-

-- task1的随机遮挡策略略显粗犷,推荐阅读《Data Nosing As Smoothing In Neural Network Language Models》。

-- [MASK]标记在实际预测中不会出现,训练时用过多[MASK]影响模型表现。每个batch只有15%的token被预测,所以BERT收敛得比left-to-right模型要慢(它们会预测每个token)。

-- BERT对硬件资源的消耗巨大(大模型需要16个tpu,历时四天;更大的模型需要64个tpu,历时四天。

-

-**评价**

-

-Bert是NLP里里程碑式的工作,对于后面NLP的研究和工业应用会产生长久的影响,这点毫无疑问。但是从上文介绍也可以看出,从模型或者方法角度看,Bert借鉴了ELMO,GPT及CBOW,主要提出了Masked 语言模型及Next Sentence Prediction,但是这里Next Sentence Prediction基本不影响大局,而Masked LM明显借鉴了CBOW的思想。所以说Bert的模型没什么大的创新,更像最近几年NLP重要进展的集大成者,这点如果你看懂了上文估计也没有太大异议,如果你有大的异议,杠精这个大帽子我随时准备戴给你。如果归纳一下这些进展就是:

-

-- 首先是两阶段模型,第一阶段双向语言模型预训练,这里注意要用双向而不是单向,第二阶段采用具体任务Fine-tuning或者做特征集成;

-- 第二是特征抽取要用Transformer作为特征提取器而不是RNN或者CNN;

-- 第三,双向语言模型可以采取CBOW的方法去做(当然我觉得这个是个细节问题,不算太关键,前两个因素比较关键)。

-

-Bert最大的亮点在于效果好及普适性强,几乎所有NLP任务都可以套用Bert这种两阶段解决思路,而且效果应该会有明显提升。可以预见的是,未来一段时间在NLP应用领域,Transformer将占据主导地位,而且这种两阶段预训练方法也会主导各种应用。

-

-

-

-## 4. 代码实现

-

-[bert中文分类实践](https://github.com/NLP-LOVE/ML-NLP/blob/master/NLP/16.8%20BERT/bert-Chinese-classification-task.md)

-

-

-

-## 5. 参考文献

-

-- [【NLP】Google BERT详解](https://zhuanlan.zhihu.com/p/46652512)

-- [从Word Embedding到Bert模型—自然语言处理中的预训练技术发展史](https://zhuanlan.zhihu.com/p/49271699)

-- [一文读懂BERT(原理篇)](https://blog.csdn.net/jiaowoshouzi/article/details/89073944)

-

-

-

-------

-

-> 作者:[@mantchs](https://github.com/NLP-LOVE/ML-NLP)

->

-> GitHub:[https://github.com/NLP-LOVE/ML-NLP](https://github.com/NLP-LOVE/ML-NLP)

->

-> 欢迎大家加入讨论!共同完善此项目!群号:【541954936】

-

-

-

-

-

-

-

-

-

diff --git a/NLP/16.8 BERT/README.md b/NLP/16.8 BERT/README.md

deleted file mode 100644

index 77ab482..0000000

--- a/NLP/16.8 BERT/README.md

+++ /dev/null

@@ -1,241 +0,0 @@

-## 目录

-- [1. 什么是BERT](#1-什么是bert)

-- [2. 从Word Embedding到Bert模型的发展](#2-从word-embedding到bert模型的发展)

- - [2.1 图像的预训练](#21-图像的预训练)

- - [2.2 Word Embedding](#22-word-embedding)

- - [2.3 ELMO](#23-elmo)

- - [2.4 GPT](#24-gpt)

- - [2.5 BERT](#25-bert)

-- [3. BERT的评价](#3-bert的评价)

-- [4. 代码实现](#4-代码实现)

-- [5. 参考文献](#5-参考文献)

-

-## 1. 什么是BERT

-

-**BERT的全称是Bidirectional Encoder Representation from Transformers**,是Google2018年提出的预训练模型,即双向Transformer的Encoder,因为decoder是不能获要预测的信息的。模型的主要创新点都在pre-train方法上,即用了Masked LM和Next Sentence Prediction两种方法分别捕捉词语和句子级别的representation。

-

-Bert最近很火,应该是最近最火爆的AI进展,网上的评价很高,那么Bert值得这么高的评价吗?我个人判断是值得。那为什么会有这么高的评价呢?是因为它有重大的理论或者模型创新吗?其实并没有,从模型创新角度看一般,创新不算大。但是架不住效果太好了,基本刷新了很多NLP的任务的最好性能,有些任务还被刷爆了,这个才是关键。另外一点是Bert具备广泛的通用性,就是说绝大部分NLP任务都可以采用类似的两阶段模式直接去提升效果,这个第二关键。客观的说,把Bert当做最近两年NLP重大进展的集大成者更符合事实。

-

-

-

-## 2. 从Word Embedding到Bert模型的发展

-

-### 2.1 图像的预训练

-

-自从深度学习火起来后,预训练过程就是做图像或者视频领域的一种比较常规的做法,有比较长的历史了,而且这种做法很有效,能明显促进应用的效果。

-

-

-

-那么图像领域怎么做预训练呢,上图展示了这个过程,

-

-1. 我们设计好网络结构以后,对于图像来说一般是CNN的多层叠加网络结构,可以先用某个训练集合比如训练集合A或者训练集合B对这个网络进行预先训练,在A任务上或者B任务上学会网络参数,然后存起来以备后用。

-

-2. 假设我们面临第三个任务C,网络结构采取相同的网络结构,在比较浅的几层CNN结构,网络参数初始化的时候可以加载A任务或者B任务学习好的参数,其它CNN高层参数仍然随机初始化。

-

-3. 之后我们用C任务的训练数据来训练网络,此时有两种做法:

-

- **一种**是浅层加载的参数在训练C任务过程中不动,这种方法被称为“Frozen”;

-

- **另一种**是底层网络参数尽管被初始化了,在C任务训练过程中仍然随着训练的进程不断改变,这种一般叫“Fine-Tuning”,顾名思义,就是更好地把参数进行调整使得更适应当前的C任务。

-

-一般图像或者视频领域要做预训练一般都这么做。这样做的优点是:如果手头任务C的训练集合数据量较少的话,利用预训练出来的参数来训练任务C,加个预训练过程也能极大加快任务训练的收敛速度,所以这种预训练方式是老少皆宜的解决方案,另外疗效又好,所以在做图像处理领域很快就流行开来。

-

-**为什么预训练可行**

-

-对于层级的CNN结构来说,不同层级的神经元学习到了不同类型的图像特征,由底向上特征形成层级结构,所以预训练好的网络参数,尤其是底层的网络参数抽取出特征跟具体任务越无关,越具备任务的通用性,所以这是为何一般用底层预训练好的参数初始化新任务网络参数的原因。而高层特征跟任务关联较大,实际可以不用使用,或者采用Fine-tuning用新数据集合清洗掉高层无关的特征抽取器。

-

-

-

-### 2.2 Word Embedding

-

-

-

-神经网络语言模型(NNLM)的思路。先说训练过程。学习任务是输入某个句中单词 ![[公式]](https://www.zhihu.com/equation?tex=W_t=(Bert)) 前面句子的t-1个单词,要求网络正确预测单词Bert,即最大化:

-

-![[公式]](https://www.zhihu.com/equation?tex=++P%28W_t%3D%E2%80%9CBert%E2%80%9D%7CW_1%2CW_2%2C%E2%80%A6W_%28t-1%29%3B%CE%B8%29)

-

-前面任意单词 ![[公式]](https://www.zhihu.com/equation?tex=W_i) 用Onehot编码(比如:0001000)作为原始单词输入,之后乘以矩阵Q后获得向量 ![[公式]](https://www.zhihu.com/equation?tex=C%28W_i+%29) ,每个单词的 ![[公式]](https://www.zhihu.com/equation?tex=C%28W_i+%29) 拼接,上接隐层,然后接softmax去预测后面应该后续接哪个单词。这个 ![[公式]](https://www.zhihu.com/equation?tex=C%28W_i+%29) 是什么?这其实就是单词对应的Word Embedding值,那个矩阵Q包含V行,V代表词典大小,每一行内容代表对应单词的Word embedding值。只不过Q的内容也是网络参数,需要学习获得,训练刚开始用随机值初始化矩阵Q,当这个网络训练好之后,矩阵Q的内容被正确赋值,每一行代表一个单词对应的Word embedding值。所以你看,通过这个网络学习语言模型任务,这个网络不仅自己能够根据上文预测后接单词是什么,同时获得一个副产品,就是那个矩阵Q,这就是单词的Word Embedding。

-

-2013年最火的用语言模型做Word Embedding的工具是Word2Vec,后来又出了Glove,Word2Vec。对于这两个模型不熟悉的可以参考我之前的文章,这里不再赘述:

-

-- [Word2Vec](https://github.com/NLP-LOVE/ML-NLP/tree/master/NLP/16.1%20Word%20Embedding)

-- [GloVe](https://github.com/NLP-LOVE/ML-NLP/tree/master/NLP/16.3%20GloVe)

-

-上面这种模型做法就是18年之前NLP领域里面采用预训练的典型做法,之前说过,Word Embedding其实对于很多下游NLP任务是有帮助的,只是帮助没有大到闪瞎忘记戴墨镜的围观群众的双眼而已。那么新问题来了,为什么这样训练及使用Word Embedding的效果没有期待中那么好呢?答案很简单,因为Word Embedding有问题呗。这貌似是个比较弱智的答案,关键是Word Embedding存在什么问题?这其实是个好问题。

-

-**这片在Word Embedding头上笼罩了好几年的乌云是什么?是多义词问题。**我们知道,多义词是自然语言中经常出现的现象,也是语言灵活性和高效性的一种体现。多义词对Word Embedding来说有什么负面影响?如上图所示,比如多义词Bank,有两个常用含义,但是Word Embedding在对bank这个单词进行编码的时候,是区分不开这两个含义的,因为它们尽管上下文环境中出现的单词不同,但是在用语言模型训练的时候,不论什么上下文的句子经过word2vec,都是预测相同的单词bank,而同一个单词占的是同一行的参数空间,这导致两种不同的上下文信息都会编码到相同的word embedding空间里去。所以word embedding无法区分多义词的不同语义,这就是它的一个比较严重的问题。

-

-有没有简单优美的解决方案呢?ELMO提供了一种简洁优雅的解决方案。

-

-

-

-### 2.3 ELMO

-

-ELMO是“Embedding from Language Models”的简称,其实这个名字并没有反应它的本质思想,提出ELMO的论文题目:“Deep contextualized word representation”更能体现其精髓,而精髓在哪里?在deep contextualized这个短语,一个是deep,一个是context,其中context更关键。

-

-在此之前的Word Embedding本质上是个静态的方式,所谓静态指的是训练好之后每个单词的表达就固定住了,以后使用的时候,不论新句子上下文单词是什么,这个单词的Word Embedding不会跟着上下文场景的变化而改变,所以对于比如Bank这个词,它事先学好的Word Embedding中混合了几种语义 ,在应用中来了个新句子,即使从上下文中(比如句子包含money等词)明显可以看出它代表的是“银行”的含义,但是对应的Word Embedding内容也不会变,它还是混合了多种语义。这是为何说它是静态的,这也是问题所在。

-

-**ELMO的本质思想是**:我事先用语言模型学好一个单词的Word Embedding,此时多义词无法区分,不过这没关系。在我实际使用Word Embedding的时候,单词已经具备了特定的上下文了,这个时候我可以根据上下文单词的语义去调整单词的Word Embedding表示,这样经过调整后的Word Embedding更能表达在这个上下文中的具体含义,自然也就解决了多义词的问题了。所以ELMO本身是个根据当前上下文对Word Embedding动态调整的思路。

-

-

-

-ELMO采用了典型的两阶段过程,第一个阶段是利用语言模型进行预训练;第二个阶段是在做下游任务时,从预训练网络中提取对应单词的网络各层的Word Embedding作为新特征补充到下游任务中。

-

-上图展示的是其预训练过程,它的网络结构采用了双层双向LSTM,目前语言模型训练的任务目标是根据单词 ![[公式]](https://www.zhihu.com/equation?tex=W_i) 的上下文去正确预测单词 ![[公式]](https://www.zhihu.com/equation?tex=W_i) , ![[公式]](https://www.zhihu.com/equation?tex=W_i) 之前的单词序列Context-before称为上文,之后的单词序列Context-after称为下文。

-

-图中左端的前向双层LSTM代表正方向编码器,输入的是从左到右顺序的除了预测单词外 ![[公式]](https://www.zhihu.com/equation?tex=W_i) 的上文Context-before;右端的逆向双层LSTM代表反方向编码器,输入的是从右到左的逆序的句子下文Context-after;每个编码器的深度都是两层LSTM叠加。

-

-这个网络结构其实在NLP中是很常用的。使用这个网络结构利用大量语料做语言模型任务就能预先训练好这个网络,如果训练好这个网络后,输入一个新句子 ![[公式]](https://www.zhihu.com/equation?tex=Snew) ,句子中每个单词都能得到对应的三个Embedding:

-

-- 最底层是单词的Word Embedding;

-- 往上走是第一层双向LSTM中对应单词位置的Embedding,这层编码单词的句法信息更多一些;

-- 再往上走是第二层LSTM中对应单词位置的Embedding,这层编码单词的语义信息更多一些。

-

-也就是说,ELMO的预训练过程不仅仅学会单词的Word Embedding,还学会了一个双层双向的LSTM网络结构,而这两者后面都有用。

-

-

-

-上面介绍的是ELMO的第一阶段:预训练阶段。那么预训练好网络结构后,**如何给下游任务使用呢**?上图展示了下游任务的使用过程,比如我们的下游任务仍然是QA问题:

-

-1. 此时对于问句X,我们可以先将句子X作为预训练好的ELMO网络的输入,这样句子X中每个单词在ELMO网络中都能获得对应的三个Embedding;

-2. 之后给予这三个Embedding中的每一个Embedding一个权重a,这个权重可以学习得来,根据各自权重累加求和,将三个Embedding整合成一个;

-3. 然后将整合后的这个Embedding作为X句在自己任务的那个网络结构中对应单词的输入,以此作为补充的新特征给下游任务使用。对于上图所示下游任务QA中的回答句子Y来说也是如此处理。

-

-因为ELMO给下游提供的是每个单词的特征形式,所以这一类预训练的方法被称为“Feature-based Pre-Training”。

-

-**前面我们提到静态Word Embedding无法解决多义词的问题,那么ELMO引入上下文动态调整单词的embedding后多义词问题解决了吗?解决了,而且比我们期待的解决得还要好**。对于Glove训练出的Word Embedding来说,多义词比如play,根据它的embedding找出的最接近的其它单词大多数集中在体育领域,这很明显是因为训练数据中包含play的句子中体育领域的数量明显占优导致;而使用ELMO,根据上下文动态调整后的embedding不仅能够找出对应的“演出”的相同语义的句子,而且还可以保证找出的句子中的play对应的词性也是相同的,这是超出期待之处。之所以会这样,是因为我们上面提到过,第一层LSTM编码了很多句法信息,这在这里起到了重要作用。

-

-**ELMO有什么值得改进的缺点呢**?

-

-- 首先,一个非常明显的缺点在特征抽取器选择方面,ELMO使用了LSTM而不是新贵Transformer,Transformer是谷歌在17年做机器翻译任务的“Attention is all you need”的论文中提出的,引起了相当大的反响,很多研究已经证明了Transformer提取特征的能力是要远强于LSTM的。如果ELMO采取Transformer作为特征提取器,那么估计Bert的反响远不如现在的这种火爆场面。

-- 另外一点,ELMO采取双向拼接这种融合特征的能力可能比Bert一体化的融合特征方式弱,但是,这只是一种从道理推断产生的怀疑,目前并没有具体实验说明这一点。

-

-

-

-### 2.4 GPT

-

-

-

-GPT是“Generative Pre-Training”的简称,从名字看其含义是指的生成式的预训练。GPT也采用两阶段过程,第一个阶段是利用语言模型进行预训练,第二阶段通过Fine-tuning的模式解决下游任务。

-

-上图展示了GPT的预训练过程,其实和ELMO是类似的,主要不同在于两点:

-

-- 首先,特征抽取器不是用的RNN,而是用的Transformer,上面提到过它的特征抽取能力要强于RNN,这个选择很明显是很明智的;

-- 其次,GPT的预训练虽然仍然是以语言模型作为目标任务,但是采用的是单向的语言模型,所谓“单向”的含义是指:语言模型训练的任务目标是根据 ![[公式]](https://www.zhihu.com/equation?tex=W_i) 单词的上下文去正确预测单词 ![[公式]](https://www.zhihu.com/equation?tex=W_i) , ![[公式]](https://www.zhihu.com/equation?tex=W_i) 之前的单词序列Context-before称为上文,之后的单词序列Context-after称为下文。

-

-如果对Transformer模型不太了解的,可以参考我写的文章:[Transformer](https://github.com/NLP-LOVE/ML-NLP/tree/master/NLP/16.7%20Transformer)

-

-ELMO在做语言模型预训练的时候,预测单词 ![[公式]](https://www.zhihu.com/equation?tex=W_i) 同时使用了上文和下文,而GPT则只采用Context-before这个单词的上文来进行预测,而抛开了下文。这个选择现在看不是个太好的选择,原因很简单,它没有把单词的下文融合进来,这限制了其在更多应用场景的效果,比如阅读理解这种任务,在做任务的时候是可以允许同时看到上文和下文一起做决策的。如果预训练时候不把单词的下文嵌入到Word Embedding中,是很吃亏的,白白丢掉了很多信息。

-

-

-

-### 2.5 BERT

-

-Bert采用和GPT完全相同的两阶段模型,首先是语言模型预训练;其次是使用Fine-Tuning模式解决下游任务。和GPT的最主要不同在于在预训练阶段采用了类似ELMO的双向语言模型,即双向的Transformer,当然另外一点是语言模型的数据规模要比GPT大。所以这里Bert的预训练过程不必多讲了。模型结构如下:

-

-

-

-对比OpenAI GPT(Generative pre-trained transformer),BERT是双向的Transformer block连接;就像单向rnn和双向rnn的区别,直觉上来讲效果会好一些。

-

-对比ELMo,虽然都是“双向”,但目标函数其实是不同的。ELMo是分别以![[公式]](https://www.zhihu.com/equation?tex=P%28w_i%7C+w_1%2C+...w_%7Bi-1%7D%29) 和 ![[公式]](https://www.zhihu.com/equation?tex=P%28w_i%7Cw_%7Bi%2B1%7D%2C+...w_n%29) 作为目标函数,独立训练处两个representation然后拼接,而BERT则是以 ![[公式]](https://www.zhihu.com/equation?tex=P%28w_i%7Cw_1%2C++...%2Cw_%7Bi-1%7D%2C+w_%7Bi%2B1%7D%2C...%2Cw_n%29) 作为目标函数训练LM。

-

-BERT预训练模型分为以下三个步骤:**Embedding、Masked LM、Next Sentence Prediction**

-

-#### 2.5.1 Embedding

-

-这里的Embedding由三种Embedding求和而成:

-

-

-

-- Token Embeddings是词向量,第一个单词是CLS标志,可以用于之后的分类任务

-- Segment Embeddings用来区别两种句子,因为预训练不光做LM还要做以两个句子为输入的分类任务

-- Position Embeddings和之前文章中的Transformer不一样,不是三角函数而是学习出来的

-

-

-

-#### 2.5.2 Masked LM

-

-MLM可以理解为完形填空,作者会随机mask每一个句子中15%的词,用其上下文来做预测,例如:my dog is hairy → my dog is [MASK]

-

-此处将hairy进行了mask处理,然后采用非监督学习的方法预测mask位置的词是什么,但是该方法有一个问题,因为是mask15%的词,其数量已经很高了,这样就会导致某些词在fine-tuning阶段从未见过,为了解决这个问题,作者做了如下的处理:

-

-80%是采用[mask],my dog is hairy → my dog is [MASK]

-

-10%是随机取一个词来代替mask的词,my dog is hairy -> my dog is apple

-

-10%保持不变,my dog is hairy -> my dog is hairy

-

-**注意:这里的10%是15%需要mask中的10%**

-

-那么为啥要以一定的概率使用随机词呢?这是因为transformer要保持对每个输入token分布式的表征,否则Transformer很可能会记住这个[MASK]就是"hairy"。至于使用随机词带来的负面影响,文章中解释说,所有其他的token(即非"hairy"的token)共享15%*10% = 1.5%的概率,其影响是可以忽略不计的。Transformer全局的可视,又增加了信息的获取,但是不让模型获取全量信息。

-

-

-

-#### 2.5.3 Next Sentence Prediction

-

-选择一些句子对A与B,其中50%的数据B是A的下一条句子,剩余50%的数据B是语料库中随机选择的,学习其中的相关性,添加这样的预训练的目的是目前很多NLP的任务比如QA和NLI都需要理解两个句子之间的关系,从而能让预训练的模型更好的适应这样的任务。

-个人理解:

-

-- Bert先是用Mask来提高视野范围的信息获取量,增加duplicate再随机Mask,这样跟RNN类方法依次训练预测没什么区别了除了mask不同位置外;

-- 全局视野极大地降低了学习的难度,然后再用A+B/C来作为样本,这样每条样本都有50%的概率看到一半左右的噪声;

-- 但直接学习Mask A+B/C是没法学习的,因为不知道哪些是噪声,所以又加上next_sentence预测任务,与MLM同时进行训练,这样用next来辅助模型对噪声/非噪声的辨识,用MLM来完成语义的大部分的学习。

-

-

-

-## 3. BERT的评价

-

-总结下BERT的主要贡献:

-

-- 引入了Masked LM,使用双向LM做模型预训练。

-- 为预训练引入了新目标NSP,它可以学习句子与句子间的关系。

-- 进一步验证了更大的模型效果更好: 12 --> 24 层。

-- 为下游任务引入了很通用的求解框架,不再为任务做模型定制。

-- 刷新了多项NLP任务的记录,引爆了NLP无监督预训练技术。

-

-**BERT优点**

-

-- Transformer Encoder因为有Self-attention机制,因此BERT自带双向功能。

-- 因为双向功能以及多层Self-attention机制的影响,使得BERT必须使用Cloze版的语言模型Masked-LM来完成token级别的预训练。

-- 为了获取比词更高级别的句子级别的语义表征,BERT加入了Next Sentence Prediction来和Masked-LM一起做联合训练。

-- 为了适配多任务下的迁移学习,BERT设计了更通用的输入层和输出层。

-- 微调成本小。

-

-**BERT缺点**

-

-- task1的随机遮挡策略略显粗犷,推荐阅读《Data Nosing As Smoothing In Neural Network Language Models》。

-- [MASK]标记在实际预测中不会出现,训练时用过多[MASK]影响模型表现。每个batch只有15%的token被预测,所以BERT收敛得比left-to-right模型要慢(它们会预测每个token)。

-- BERT对硬件资源的消耗巨大(大模型需要16个tpu,历时四天;更大的模型需要64个tpu,历时四天。

-

-**评价**

-

-Bert是NLP里里程碑式的工作,对于后面NLP的研究和工业应用会产生长久的影响,这点毫无疑问。但是从上文介绍也可以看出,从模型或者方法角度看,Bert借鉴了ELMO,GPT及CBOW,主要提出了Masked 语言模型及Next Sentence Prediction,但是这里Next Sentence Prediction基本不影响大局,而Masked LM明显借鉴了CBOW的思想。所以说Bert的模型没什么大的创新,更像最近几年NLP重要进展的集大成者,这点如果你看懂了上文估计也没有太大异议,如果你有大的异议,杠精这个大帽子我随时准备戴给你。如果归纳一下这些进展就是:

-

-- 首先是两阶段模型,第一阶段双向语言模型预训练,这里注意要用双向而不是单向,第二阶段采用具体任务Fine-tuning或者做特征集成;

-- 第二是特征抽取要用Transformer作为特征提取器而不是RNN或者CNN;

-- 第三,双向语言模型可以采取CBOW的方法去做(当然我觉得这个是个细节问题,不算太关键,前两个因素比较关键)。

-

-Bert最大的亮点在于效果好及普适性强,几乎所有NLP任务都可以套用Bert这种两阶段解决思路,而且效果应该会有明显提升。可以预见的是,未来一段时间在NLP应用领域,Transformer将占据主导地位,而且这种两阶段预训练方法也会主导各种应用。

-

-

-

-## 4. 代码实现

-

-[bert中文分类实践](https://github.com/NLP-LOVE/ML-NLP/blob/master/NLP/16.8%20BERT/bert-Chinese-classification-task.md)

-

-

-

-## 5. 参考文献

-

-- [【NLP】Google BERT详解](https://zhuanlan.zhihu.com/p/46652512)

-- [从Word Embedding到Bert模型—自然语言处理中的预训练技术发展史](https://zhuanlan.zhihu.com/p/49271699)

-- [一文读懂BERT(原理篇)](https://blog.csdn.net/jiaowoshouzi/article/details/89073944)

-

-

-

-------

-

-> 作者:[@mantchs](https://github.com/NLP-LOVE/ML-NLP)

->

-> GitHub:[https://github.com/NLP-LOVE/ML-NLP](https://github.com/NLP-LOVE/ML-NLP)

->

-> 欢迎大家加入讨论!共同完善此项目!群号:【541954936】 diff --git a/NLP/16.8 BERT/bert-Chinese-classification-task.md b/NLP/16.8 BERT/bert-Chinese-classification-task.md

deleted file mode 100644

index 5e15002..0000000

--- a/NLP/16.8 BERT/bert-Chinese-classification-task.md

+++ /dev/null

@@ -1,46 +0,0 @@

-# bert-Chinese-classification-task

-bert中文分类实践

-

-在run_classifier_word.py中添加NewsProcessor,即新闻的预处理读入部分 \

-在main方法中添加news类型数据处理label \

- processors = { \

- "cola": ColaProcessor,\

- "mnli": MnliProcessor,\

- "mrpc": MrpcProcessor,\

- "news": NewsProcessor,\

- }

-

-download_glue_data.py 提供glue_data下面其他的bert论文公测glue数据下载

-

-data目录下是news数据的样例

-

-export GLUE_DIR=/search/odin/bert/extract_code/glue_data \

-export BERT_BASE_DIR=/search/odin/bert/chinese_L-12_H-768_A-12/ \

-export BERT_PYTORCH_DIR=/search/odin/bert/chinese_L-12_H-768_A-12/

-

-python run_classifier_word.py \

- --task_name NEWS \

- --do_train \

- --do_eval \

- --data_dir $GLUE_DIR/NewsAll/ \

- --vocab_file $BERT_BASE_DIR/vocab.txt \

- --bert_config_file $BERT_BASE_DIR/bert_config.json \

- --init_checkpoint $BERT_PYTORCH_DIR/pytorch_model.bin \

- --max_seq_length 256 \

- --train_batch_size 32 \

- --learning_rate 2e-5 \

- --num_train_epochs 3.0 \

- --output_dir ./newsAll_output/ \

- --local_rank 3

-

- 中文分类任务实践

-

-实验中对中文34个topic进行实践(包括:时政,娱乐,体育等),在对run_classifier.py代码中的预处理环节需要加入NewsProcessor模块,及类似于MrpcProcessor,但是需要对中文的编码进行适当修改,训练数据与测试数据按照4:1进行切割,数据量约80万,单卡GPU资源,训练时间18小时,acc为92.8%

-

-eval_accuracy = 0.9281581998809113

-

-eval_loss = 0.2222444740207354

-

-global_step = 59826

-

-loss = 0.14488934577978746

diff --git a/NLP/16.8 BERT/data/dev.tsv b/NLP/16.8 BERT/data/dev.tsv

deleted file mode 100644

index 2ff6836..0000000

--- a/NLP/16.8 BERT/data/dev.tsv

+++ /dev/null

@@ -1,30 +0,0 @@

-game EDG����ϣ���������������ʦ��ʾ��������̭�� ����Ϸ������ԭ������ֹ��վ��������õ�ȡ��Υ�߱ؾ���Fnatic�����ʦ�ɹ�����ʾ������һ�����������Ʊȫ���Ľ�����ǿ�����Ŷ���ACD�����0-3ս����˵�Ǵ���������ǵ�ʿ������Ϊ0-3�Ŀ��֣�����Ϊ��ֻ�������۳��ߵĿ��ܣ���������֮ǰ��������ʵ���ߵķ�ʽ�кܶ��֣��������١�ֻ������Ҫһ������Ķ�ս���֡���Fnatic��ʦ���조��ʱ�����˺͡������Ĵ���˵���������Ҳ���ǡ�С����6-0������2-4���������·�ߡ�����Fnatic����״̬���ã�һ����4-0ʵ����ת������˫ɱIMT��GAM���°�ǿ��Ʊ�����Ŵ��LZһ���������ô������ô�õ�һ����ʦ��ʾ����EDG�Ľ����Dz��Ǹ������أ�һ���������ɣ�EDGС����֣�SKT��C9��AHQEDGҪ���������Լ����뱣�ֺ�״̬����õijɼ���Ȼ����սȫʤ������ѡ��Ҳ��ֻ�����SKT���������ӱ���ȫʤ��ӮC9C9��IMT���DZ���ս�ӣ������С��ڶ��ֺܲˡ���Buff�ӳɣ�C9��S5��ʱ���һ�־���ȫʤ�����ǵڶ���ֱ�Ӻͽ����IMTһ�����������������̭�������C9�ⲻ��Ҫ��������Buff����һ�֡�EDGӮC9���ѣ���Ӳʵ����˵C9ԭ���Ͳ�������EDG�Ķ��֡���һ�ֵIJҰ�������¬����ǰ�ڷ��������ƣ�C9������������ϵ�õ��������ӡ�ֻҪ��ܵ���һ�ֵ���Щ���ȶ����أ�ƴ�汾�������Ͷ���EDG����ȫ�������ɻ���C9�ġ�ӮAHQAHQҲ���ѣ�EDG�������AHQ����Ҫ�����к��ڵ��Dz���ָ�ӳ���ʧ�������Ӳʵ����������AHQ���е�ȷʵû��EDG���㣬���������Ż����油��ֻҪScout�����ߣ�EDG���Ի���AHQ������Ҫ˵��EDG��սAHQ��SKT�����������Ϊʵ����ǿ�����ж�����Ϊ������һ������սָ�Ӿ����ϳ��ֵ�����ʧ�������ԭ�������Ƶ�EDG�����̡�����һ�����ڵ�ʱ�������EDG�ѵ����ܽ���Լ���ʧ�����������ֱ���������EDG�����������Ƿ�����ӮSKT��SKT�����DZȽ����ѵ�һ�����֣��Ͼ�����SKT�ķ�������������Ǿ��Բ����ٸ�EDGһ������1�����ƵĶԾֵġ�����EDG����Ӧ�ÿ���Ч�µ�һ�ֵ�ս������ɱ��ijһ·��ʼ��������Faker������Ұ����������ʵ������SKT��ϵ�л���ͦ����ǰ��ץ���ġ��������ֶ�սSKTʱ����Fakerץ���ˣ����ŵڶ������ı���Ӧ��Ҳ����EDG��ϣ������SKT��Ҳ�нϴ�ϣ������3��ʤ������Ǵ��3-3����ôEDG���ߵĸ��ʾͻ�dz��ߡ�4-4��������������һ�����SKT����Ҳû��ϵ������Fnatic������õ����ӣ�����Ҳ�����LZ��������Ȼ��2-4�Ļ��ִ��˼�����������ҪC9��AHQ�ĶԾ���������֣�Ҳ����C9����Ӯ��IMTһ��2-4���ף�AHQӮ��C9���SKT��EDG���������������SKT֮�⣬ȫ��2-4�Ļ��ִ�����ˡ���EDG��ʵ�������������־��кܴ������ˣ��������������������ض���EDG�ڶ��ֻ�����C9��AHQ��������Ҳ�����ƣ������ͻ�������ˡ�������ʱ���ܵ���˵EDG���߲����ѣ�����ҪEDGѧϰ�����Fnatic���Լ���״̬����á������ͳ��ߵĸ���·��������Ҫ�������Լ���2ʤ����ս���ġ�Fnatic����ս���������Խ�����EDGƾʲô�����أ����Բ�Ҫ̫����EDG�������ǵ�ʵ�����������ѡ�ϣ��EDG�ܹ��ú�ѧϰ��Fnatic���LPL����Ϯ�ɣ���Ȼ�����Ҫ����һ�㣬EDG������սȫʤ3-3�����SKT���õ�4ʤ���ˮ���õ�3ʤ��C9��EDG���ǻᱻ��̭��...���ԣ��Լ�Ŭ��ҲҪ��������ս�ӵı����ˡ�����Ϸ������ԭ����δ��������ֹ����ת�ظ�л��λ����������֧�����~���Ĺ�ע���������dz������µĶ���

-game CSGO��ҡ���ţ��������һ���±� ���б�CTץ������ �ش�ϲѶ��CSGO��ҡ���ţ���������Ѿ����ɹ�ץ�������ò�˵�������Ч�ʻ����������ġ� �����õĽ϶��һ����ҳ���˵�ټ��������Ļ����϶�Ҳ���������������������������һ��ȥ���������Ϸ֣�����Ҳ��ȥ�����ˣ����ڼ������������ô���ľ����ˡ� ˵����С�������ڹ��ʷ���Ҳ����Щ����������ʹ����Ű�IJ��ɾ��Ϸ�ˡ�������Щ�������ڿƼ�ʹ����֧�������� ���ֶ��������ˣ��ͱ����̱�ͷ���ͱ���ǽ��ͷ�ȵȿ��ŵĻ�ɱ��ʽ��������˺����Ҷ���Ϸ��ϲ�������Ҹе��˾����� ����һ�Ⱦ��������ڹ���һЩ�еķ���Ҵ�ʩ�п�����ϣ�������룬�ѵ�������һ�����鵽��δ�Ĺ�ƽ�����������������������������е�С������Ȼ���е������̡� �������������� �Դӹ�����ʼ���е���������ʱ��������ػ��Ѿ����δ�ķ���ˣ���������������2W���ҵ��ʺ��ˡ���һ�������ν����Ĺ��� �������˻�ϲ�ľ����ʼ�ᵽ��CSGO������̵���ҡ���ţ�������߱�ץ���ˣ��ڶࡰţ���ӡ����ҿɹ飬��ν�Դ�ϲ�� ���������ˡ�CSGO��ţ����������ij�����б�ץ�� ��������ҿɹ�ġ�ţ���ӡ�������Ѿ����ҵIJ�֪�����ˡ� ij����ţQQȺ���Ѿ����������� ������ֱ��QQȺ����CSGO�����ؼ��ʵ���ЩȺ���Ų��ٵ�Ⱥ����������������˵ġ���ţȺ���ɡ� �����ﲻ�ò�˵һ�£����������Ķ�����ȫ�úܶ��Ȱ�CSGO��ҳ�����һ�������裬����Щ�������ӵ���������Ǿ��ų�һ���亹�� ������ֱ������AWPһֱ������Щ������ߺ����ʹ���ߡ��͵���¶ͷ��Ȼ��һǹ�������ǵĹ�ͷ�� �ҹ��������Dz��Ǹò����ˣ����ǵġ���ʳ��ĸ�����Ѿ��������ˣ��������ͻ��ֵ������ˡ� ���ž���������һ�����ֵĴ����������Ļ�����úܶ࣬���ɴ�ܵij���Ҳ�����˺ܶ࣬�������ֲ�Ҫ�����ˡ� ����˵��������ʱ�������������һ��������RUSH B�ɡ�

-game LOLŮ����������������Ҳ�����ʤ�ʶ������˻������в��� ���ںܶ�ϲ��ADC�������˵��ǰ�����汾���ȵ�Ů�������ձ��Ӷ�����������ȷʵ���˿�����Щ���ۣ���Ϊ�������������ÿ������ڴ�֮��û���˵dz��Ļ��ᣬ�������º���������ͳ�ƣ����Ů����ʤ���Ѿ��ǵ�����һ�ˣ� ����Ҫ˵��������IJң�������İ���Ⱥ�۵ĵ�һ�����̶�1����ʱ������˵�����һ�����ںܶ��˻����ڴ�ȭͷ�ܹ�����λADC���м�ǿ��ʱ����IJ��Է����������˵����� ��Ϊ�������������ˣ� ��ε������ٴ����Ů���ļ��ӽ��иĶ�����������������ܵ�ʱ�䣬���һ������˼��ӵij���ʱ�䣬��ǰ���˵���������к��ڻ�������һ��Ļ������ڵĻ��dz����ˣ� ������Ҿ�����̳ŭ��ȭͷ����������ý���ƽ���С������ Ŀǰ7.19�汾�IJ��Է����ڱ��ܼ��������������������Ķ����ص�����ôŮ�����Ӣ�ۻ�����������GG�ˣ�

-game ���ֿ��Ρ����ڴ����ּ��ӸУ���Ҫ����IJ��Ǿ������Ա�� ������Ϸ�Ƽ���������Ƥ���������������С�ǡ�Ŀ�������汦����ʦ��˵����Щ���ڴ����֡��ؼ��ʸ�λ�ɻ�����������ɣ�������ͯ��Ŀ���ʱ�⣿�����ڡ�������Ϸ���У�������Ҫ�Ƽ�����Ʒ���ǡ������Σ�Pokemon������������Ϊ���ֿ��Σ�Workemon�������ֻ���Ϸ������Ϸ����������Ա�ɿ��������ֿ��Ρ���һ�����淨��Ч�¡��ڴ����֡�����Ʒ��������Ʒ�ʱ������կƷ��Ϸ��֪��Ҫ�ߵ�����ȥ����Ϸ�У��㽫��Ϊһ�����������̳��ϵ��Ĺ�˾��Ŀ���Dz�������Ա������Ϊѹկ�Ͷ����Ĵ�ʦ�����ڴ�����ʽ�Ŀ�������Wokremon������Pokemon���ֿ��Ρ���һ��������Ȥ��ģ�⾭Ӫ��Ϸ������Ϸ����ҿ������鸻������CEO���ģ����˹����Լ�����Ǯ���ϵ��Ǽ̳е���һ�ҹ�˾�������Ϸ���ռ�Ŀ����Ǿ�Ӫ����ҹ�˾������Ҫ������ļԱ������ͬʱͨ���˿�нˮ��ѹեԱ���Ͷ��������ӹ�˾�����档���̳��ϵ�����־ ��Ϊ�Ե��ܲá��ֿ��Ρ����淨��һ���̶��Ͻ���˷���ȫ��ġ��ڴ����֡���������ս��ģʽ��ͼ���ռ�ϵͳ�������˼��ӸС���ʽ������Ա��ȡ���˾��飬�����Ҫ����Ӧ��ͼ������ͨ������ķ�ʽ����Ƹ���ǣ�������ģ�¿ڴ����ֵ��Ŷ��������˸е�����һЦ������Ϊ�˻�ԭ��ҳ��νӴ��ڴ����ֵĸж�����Ϸ�Ŀ�����·��ֱ���ڴ�һëһ������ս����ͼ�����ֿڴ���Ҫѱ����ЩҰ��Ա�������IJ��Ǿ����������Ҫѹ�����ǵ�н���ڴ�����ѹ���ǵ���������,ֱ������Ը�������ţ����Ϊֹ���ɹ��������ܴ�����˾�ϰ࣬Ϊ�����ҵ�������档���Գ��˿ڴ����ֵ�Ҫ���⣬������ʵ���淨���Ǿ�Ӫ���ɡ���Ȼ��Ϸ����ѹե�Ͷ�����������Ҫ��Ҫ����һ���ϰ壬���ǵð�ʱ��Ա�������ʣ�Ҫ��Ȼȫ����·�Ļ�����˾Ҳ�������Ʋ��ˡ����������ϰ廹��ѹեԱ���Ͷ��������ֿ��Ρ��ľ�ӪҪ���쳣�ḻ���������ﻹ���ǽ��ܲ��꣬�������ϵ����̾���Ϊ����Ա����ѵ��Ա��������Ӫ�գ�����˾�������������ڿ������Ĺ�λ�������µ����������˹�����������������ߵȣ���Ӧ��������Ŀֻ��٣������Ϸǰ�ڳ������ʽ���ľ���������㲻��봽�ֻ��ͨ���ۿ������ȡ����Ľ�ҡ�����Ҫ��Ǯ����Ŀ�ܶ࣬ȱǮ���ι��ɡ��ֿ��Ρ����˻���ڴ���֮�⣬��Ϸ��������������Ȥ������¼���������Ұ�Ⲷ��Ա��ʱ����û����������Լ��С�����ϵ��������������ܺ���ܵõ�һ��Ǯ����������ᷢ������ļ���Ҫ���н�¼�����Ϊһ���Ե��ܲã�˭�Ҹ��㿪��̸�ǹ��ʾͿ�������ץ�������ˡ����ܽ���˼����ؽ���ˡ��ڴ����֡���ȴ�ֲ�ֹ��ģ�¡����Լ��ḻ����Ϸ�淨�������˻���һЦ�Ĺ���������˵�����ֿ��Ρ������Ϸ�Ŀ�������Ȥζ��ȷʵ�����ڷ�����ƵĿ���Ӫ��Ϸ������������Ƽ�����λ���档�����Դ��������ԣ��״�������Ϸʱ����ѡ���������Ϸ�����ڰ����г���

-game ��ս���������DZ��������̵���ս����˵ļ��� ��Ҷ�֪����Ͽ���е�ÿ��Ӣ�۶��и��Ե��ص㣬��Щǰ��ǿ�ƣ���Щ�����������������ЩӢ���������Ƕ����˵Ĵ��ڣ�������ս�������˱�����������С�ſ�����������ЩӢ�۰ɣ�һ�����ļ������ϰ��Ӣ�ۣ�ÿ�����ܶ��ܶ��ģ�2���ܵĶ��������������˵���ը�����п��������Ǹɴ�Ѫ������ʱ���м��ټ��ܣ����������ϡ���������������������ڲ��Ƿϲķ�ʦ�ˣ���Ͽ�������Ƿ��˵��ң��Ż���÷�һ����ض��ǣ����г����˺������˸����ĵ��Ǵ����氮����Ƥ������褣������ֳ�һƬõ�廨�����������������ߵ�Ӣ�ۣ���������Ӣ���²��¡���ս�е��������˷��е������ˣ����Ŵ���ͻȻ��Ѫ�����ˣ����������Ҫȥ�к��ţ�����һ�������ܾͶ����㲻֪������ȥ�ˡ�С���������ұ������ġ�������ս�е���һ����ʺ�������۶�ô���������ͣ�ֻҪ����������϶����㶥���ķ����ѣ���������������������û��ͻȻ���ֺ�ת�����ܣ������Ҳ���Dz���Ҳ���ǡ�

-game LOL����������������ԭ��������¯��ļ�ǿ�� ����Ϸ������ԭ������ֹ��վ��������õ�ȡ��Υ�߱ؾ�LOL����PBE���ռ���7.19�汾���£�������������ԭ�����ߣ�Ӣ�۸Ķ�ƽ����ȻΧ����Ů�������ȵ���չ����װ��������¯�ٴν�����ֵ������������һ������������Ľ��������ɣ�������������ԭ���������������������ٻ�ʦͷ������Ƥ���Ķ����������Լ��ع�����Ƥ���ֱ����Ӵ��л��ƶ�����Ч�����������ƽ�ף����ع����ǹ����䡣�ع�������ЧӢ�۸Ķ�����W������ǰ�Ķ��������ü��ܻ�ɱĿ�����Ч������������Է�������һ��ֵ�����˼�ǿ�Ķ�����ԭ������Ļ�ɱ����6/8/10/12/14���ӵ�20/25/30/35/40��������Ի���һ�β�С�ļ�ǿ�����������������ڻ�����ǰ�ڶ���ʱ��վ����������֪�����ʦ��˸Ķ����У��Dz������������ط��е�Carry��λ���أ�Ů��W���ܳ���ʱ���30/22/16/12/10��Ϊ30/24/19/15/12�������Ĵ�ȫ�ȼ�30�½���20�������ʱ���30/40/50/60/70���Ϊ30/35/40/45/50�롣һ��ƽ���ԵĸĶ�������ʱ��ӳ������Ľ��ͣ�����ʱ���̡�Ů���ļ�������Ȼ���ã����Ǻ��ڵ�ʱ��������20�룬���ϳ��ܵ�Ӱ�죬���ڵļ��������������������С����������Ů������[��Ч��]��Ŀ�귨������Ҳ��ɶ����ħ���˺���W������ȴʱ����12/11/10/9/8��Ϊ���еȼ�8���˺���60/115/170/225/280��Ϊ60/105/150/195/240���ٳ���ʱ���3�뽵�͵�2��ƽ���ԵĸĶ�����ȴʱ������٣��˺�����������ʱ�����̡�װ���Ķ���¯����ǰһ�������Ѿ��ӹ̶���ֵ�Ļ��ϰ汾������Ч���Ĺ����ٶȼӳɴ�[20-35%]��Ϊ[20-40%]�����˺���[20-35]��Ϊ[20-40] [��Ч��]Ψһ�����������ٶ�/���л�Ѫ��Щ����ӳɽ�������Ҳ������ʩ�����Լ�����û��������PBE���Ե�����¯�����Ǹĵ�����������¯�����������Լ������趨��������¯�ڸ������ͷŻ��ܼӳɵ�ʱ��ͬ����Ч��ҵ��������ʩ�����Լ�������������Ӣ�ۻ��������dz�����Ϊ��������A�˾Ͳ�����δ���ӹ��ٺ���ѪЧ��������ADCӦ�û���ס���ȻĿǰֻ���ڲ��Է��ĸĶ����Ƿ��������ʽ���д�δ���IJ��Խ��������������ҫ�۸��2500�ǵ�2650���ϳɷ��ô�950��ߵ�1100�����˵ľۺ��ܳɱ���2200��ߵ�2250���ϳɷѴ�200��ߵ�250������Ϸ������ԭ����δ��������ֹ����ת�ظ�л��λ����������֧�����~���Ĺ�ע���������dz������µĶ���

-game DNF����������ǹ�ͺ�ǹְҵ, ʷʫ��������һ�� DNF����������ħǹʿ����ְҵ����ǹ�ͺ�ǹ��������ְҵ��������������ħǹʿְҵ����ô������ְҵ��ʷʫ�����������Ѿ����£��������ֻ�Ǽĺ���һ�£�������Ҳο�����ô���Ƚ��ܵ�����ǹ��ʷʫ��������ǹ������60-90�������ֹ�����û�к�����ֻ�����Ժ�����60ʷʫ��������ǹ����BUFF+2��15������+5,30������+3,35������+3,45������+2�������ٶ�+10%������˵���������BUFF���͵�������70��ʷʫ������ǹ�˼���+3������+3%��ǹ�˻ָ��ٶ�+40%��ǹ�������ȴʱ��+50%������˵���������ר��Ϊǹ�˼��������ġ�75��ʷʫ�������ͷ�+2%����ǿ+18�������Թ�����ħ��+2%������ʱ����8%�Ļ������˺���30�����ܹ�����+20%��40�����ܹ�����+20%��80��ʷʫ�������ͷ�+2%����ǿ+32�������Թ�����ħ��+2%������ʱ����17%���˺�������ʱ5%������500PX��Χ���������5�����硣85��ʷʫ�������ͷ�+2%�������Թ������ﱬ+5%��ħ��+7%��������ħ��������������+13%������ʱ����30%���˺�����̡�����״̬�·������ڡ�90ʷʫ�������ͷ�+2%���ﱬ+6%��ħ��+8%������ʱ����17%�˺�������ʱ��100���ڣ���������ʱ�˺�������5%��������(�������40%��CD0.1��)��90ʷʫ�������ͷ�+2%��ħ��+2%�����й�����+18%��װ������������BUFF������150S�������ٶ�+10%���ͷ�+15%������ʱ���˺�������35%�ĸ������ӡ�������ǹ��ʷʫ��������ô��ǹ��ʷʫ��������Щ?60ʷʫ����������ǹ60ʷʫ����һ������һ��BUFF���͵�������70ʷʫ�������ͷ�+4%��ħ��+2%��������-1%�������ٶ�+30%������ʱ5%�ļ�����30S�ڷ������壬�����������������30%�������ٶȡ�75ʷʫ������Ͷǹ��ͨ����+4������ʱ�˺�+20%��80��ʷʫ������35��������ȴʱ��-20%��45�����ܹ�����+25%����ը��Χ+30%������ʱ����18%���˺���85��ʷʫ������һ����������+1������ʱ����25%���˺������й�����+17%��500PX��Χ�����ж�Ա�Ĺ���+10%������+10%���ͷ�+15%��90��ʷʫ������Ͷǹ��ͨ+1��һ����������+3������ʱ�˺�������42%�������ӣ����ܹ�����+10%��90��ʷʫ�������ͷ�+4%���������Կ���+35��ħ��+2%������-1%������ʱ��������BUFF������ʱ35%�����˺�������ħ������������+18%���������ǹ�ͺ�ǹ�������ܣ�������������ħǹʿְҵ���������Ƿ���ñȽ����죬����һ���?���������������ְҵ�����ǻ�����?

-game Ӣ������7.18���Է����������S7����Ƥ�����ߣ����Ӣ�۸Ķ� 7.18���Է�Ϊ�����ܵĸĶ��Ѿ������ˣ����ڱ����������������Ԥ�����ܸ��£�����S7ȫ���ܾ����ı����汾����Ҫ��Χ������������ƽ����иĶ����������Է����ڰ�����Ů��Υ����Ƥ�����������羺Ƥ����ϣ����ϣƤ��������Ƥ�������۰ٷֱȻ���뵽����������ء���Ƥ���Ϲ�ս�� ���������(1350RP����ħ�ڡ�����Ƥ��ͬһ��ϵ��)�ھ�֮ʸ ��ϣ(1350RP��S7ȫ���ܾ����羺Ƥ�������۰ٷֱȼ���S7�����)���ٻ�ʦͼ��2��ھ���ϣ������ͷ��3����ģʽ����ͻ��������ͷ��2��S7ȫ���ܾ���������ͷ��55��S7ȫ���ܾ�����ض��������ͷ��ֻ�н���S7��24֧����ͷ�������������Ƥ��1��S7ȫ���ܾ�������������Ƥ��1��S7ȫ���ܾ����Ľ�ɫ��������Ƥ��(ֻ���ù�����ϵͳ����)���Ų�Ƥ���������� ������(������ɫ)�ھ�֮ʸ ��ϣ(��ɫ��ֻ��ͨ������ϵͳ����)�±�������5��Ӣ�۵������������45��S7ȫ���ܾ�����ض����������������¾���ģʽ����ͻ������Խ�Ϸ����в���S7ȫ���ܾ�����������¼�������ų��¶��ļ���ͼ�����¶�������ٻ�ʦͼ����S7ȫ���ܾ���Ͽ�������Ѿ����ӵ��ͻ��˿ͻ������������������ез�����Ĺ��ܴ�������������������Ƥ���������������н���Ӣ�۸Ķ����ὣħ ���п�˹Q���ڰ�֮Ծ�ڷ��п�ʼ��ʱ����Ϊ�����赲��̬���ڷ���·���пɱ����ɳĮ�ʵ� ���ȶ�R������֮ǽ�˺���150/225/300���ӵ�150/250/450ħ��֮ӵ ���������E��˫���������ж�Ŀ����ɵĶ�������˺���15/40/65/90/115���͵�10/30/50/70/90AP�ӳ���0.4���ӵ�0.5֩��Ů�� ����˿W���Ա�֩��(����̬)�����˺���60/110/160/210/260���͵�55/95/135/175/215AP�ӳɴ�0.8���ӵ�0.95E����˿(֩����̬)��ȴʱ���26/23/20/17/14�����ӵ�26/24/22/20/18����˫���� �ư��ȱ���������֮�����������ٴ�15/25/35/45%���ӵ�20/30/40/50%R����˫��ս���ڷư�����Ŀ�긽��ʱ����þ���֮��Ķ������ټӳ���ʧ֮�� �ɶ�һ���������ֵ��540���͵�510��Ͱ ������˹һ��������״�29.05���͵�26.05E���ⵯ���������ĩ�˵���ײ������� ����E���ֶ��ùϻ����˺���50/70/90/110/130���ӵ�60/80/100/120/140�˺���AP�ӳɴ�0.7���ӵ�0.8�������ǻ��� ��������W���ƽ�ʥ�ܻ�������ֵ��65/90/115/140/165���͵�60/85/110/135/160ÿ��һ���з�Ӣ���ṩ�Ļ���ֵ��2/2.5/3/3.5/4%���͵�2/2.25/2.5/2.75/3%äɮ ����W�������ֻ���ֵ��40/100/160/220/280������55/110/165/220/275ʥǹ���� ¬����E���������ȴʱ���18/17/16/15/14�����ӵ�22/20/18/16/14���̩̹ ŵ����˹Q����ͨ��������ֵ���Ĵ�60/70/80/90/100���͵�ȫ�ȼ�60������������˵��Σ�����һ�뷨��ֵ���Ŀ�ҰŮ���� �ε���E��Ұ�Ա���(����̬)AP�ӳɴ�0.275���ӵ�0.325ɽ��֮�� �¶�������������ʦ���ڰ¶��ﵽ13���������������װ��W��������Ϣ�˺���Ŀ�굱ǰ����ֵ�ٷֱȵ�����Ŀ���������ֵ�ٷֱ�ע��ò�����ʦ��ʾ����Ķ�ȡ���˰�֮���� ���Ӷ�һ��������״�22���ӵ�25���ķ�ʦ ����W�����Ľ���AP�ӳɴ�0.2���ӵ�0.6�������� ��˿����E����ը����AD�ӳɴ�0.5/0.65/0.8/0.95/1.1���͵�0.5/0.6/0.7/0.8/0.9װ���Ķ�������������ֵ��325���͵�300����֮����ȴ������10%���ӵ�20%�ܼ۴�2200���ӵ�2300��˪Ů�ʵ�ָ����ȴ������10%���ӵ�20%�ܼ۴�2200���ӵ�2300��˪֮����ȴ������0%���ӵ�5%��ʿ֮���ܼ۴�2300���͵�2200����ֵ��350���͵�250ע��ӡ��������Ķ��ǻع����ָ����ص���ʦ��(�¶������棬Ť�����ֵ�ͼ)�ܼ�4550���ϳɼ۸�1050+55APע������7.17�汾�������ݸ�������֮��(�¶�������)����ֵ��38+22*�ȼ����͵�35+22*�ȼ���������Ѿ���ȥ5�����ܵ�������������֮ϻ�Ļ���Ч������û���Ч��������0ע��ӡ�������ʦ��ʾ�����BUG������(��-�¶�������)�ϳ�·�ߣ����ɳ©+1000���ܼۣ�3900��+100AP(+30AP)+60����(+15����)

-game LOL��˵ʮһ��ӵ�ұ�����Ԫ���պ����ǵã�ѧѧ�˼ң��ٿ����㣡 LOL��˵�ǵ���ʵ�ӵ�������LPL��˵̨�ͱ��ܺܶ��˵Ĺ�ע����Ȼ����������짵���ŵ��������Ƿз�����������Ÿ��ʧ�ܣ����CP����Ҳֻ����ͬ�����������ǵ���Ȼû�зŹ�Ư�����ӣ�����ͱ������ڽ�Ŀ�б�����Ҫȫ��2017���������ӵ���ʲô�ġ� ���ڽ���ı������������DZ���Ԫ�úõij�����һ���� �����������ģ���˵ʮһ�Ǵ�ҹ��ϵ������ӣ�������Ҳ��ɹ����һ�źʹ�����Լ������ĺ��� ������Ԫת������@�˼ǵã�����ɹ��һ��ʮһ����������һ�����Ƭ���ǻ�������ǡ����� �ǵõ�Ȼ�����˷���������ʾ�Լ�Ҳ����ӵ�ұ�����ֻ�����������զ����ô���Ծ��أ� ������ǵ���ʦ���Ͻ��Ҹ�Ů���Ѱɣ�

-game ����ACG��һ�ң����˶���Ԫ����������ﻹ����Ϸ��ҵġ���"�� ��ͬ�����ɡ�����������ͬ�����������ˡ�����Ȼ�Ѿ��㲻����һ������Ϸ�ˡ����������2014 �� 6 �� 25 �յ�½�ƻ�ƽ̨ Playstation mobile������2015��7��תսiOSƽ̨�������������iOSս����ʼ�㣬������Ҳ�нӽ�3���ʱ�䡣�����Ѿ����ӽ�3�꣬�����Խ�����۹���������ͬ�����ɡ���ȻҲ��һ���Ʒ�ʼ��ߣ����Ҿ߱����ߵı�ʶ�ȵ����Ρ���ͬ�����ɡ���ѡ���ϵ���ɫ֮һ������¼�˴�������Ԫ���������Ŀ��������Bվ���ܺ�����V��ϵ�С����еġ���ͨDisco�����ǿ�νBվ������2016������ں������ӵĿ����ݳ������ݳ�����ͨDisco���������˼��ߵ������ȳ���Bվfans�ױ�ʾ���ǡ������˴�Ԫ�ڡ� ����ʷ��ʱ�̡�����֮�⣬�������粻ͬ����Ƶ�������棬Ҳ�á�ͬ�����ɡ����Ӿ������˾��ö�Ŀһ�¡������ǵ�����������ԻøУ����Ƕ���Ԫ����ʱ�Ķ��������⣬�������ֱ����кϵ�ʮ�����С��ڹ�������Ŀ�������У������ö��ҡ��������ַdz��ŷ������ȡ���������г�����miss��2015��7�¡�ͬ�����ɡ���iOS�ϼ�ʱ����Ϸ��ֻ��21����������2017��2�£���ͬ�����ɡ�����¼����Ŀ�����Ѿ��ﵽ��100�ס�����һ��������˵����������㲻��̫�ߡ���������ǰѡ�ͬ�����ɡ��бȽ���Ҫ�������ĸ�����һ����Ҳ����������V�Ҷ���Ԫ��֮�⣬����һЩ�����Ķ�������ͬ�����ɡ������µ�һ�θ����У������˺�����galgame��NEKOPARA������������������������������լ���������Ѿõ���Ϸ��������������ܡ���˾��ֻ��Ҫ����������Ŀ����λ����Ů��װ�������ӣ���¶���˻��ĵ�Ц�ݡ����������������ԡ�ͬ�����ɡ���˵��Ͳ��ǵ�һ���ˡ�2016��5�£��߿�֮ǰ����ͬ�����ɡ��Ƴ��ˡ��߿�����100�졷��������������������������Ϸ����ν������ѡ����������Ǹ���һ��ͬ�߿�����Ϸ������ϵ��һ��İ��������ڡ�ͬ�����ɡ������������У��㻹�����ҵ��ڶ��ƽ̨�϶����¼Ѽ��ġ�ICEY������Ը�Ϊ��ҵ�������Ρ���Ů����ǹ��������Ůǰ�ߡ���������������Щ��Ϸ�������ٵĴ��Ŷ���Ԫ�����ԡ�������˵�����Ƕ���Ԫ���ȵ㣬����˵��Щ����Ϸ���������ȵ㡣ͬ��������������ģ����С����롶OPUS����ƻ����������µ��ŵĶ�����Ϸ������������Щ��Ϸ��Ʒ���ȶȲ������ر�ij��ã����������ӵ�м��õĿڱ�������֮�⣬��ͬ�����ɡ��������ˡ����桱������ֽ��������λ�����ȶ���������⡣���������������֮���ѡ���ϣ����Ƿ·��ܿ�����ͬ�����ɡ�������������һλ��Ϸ����˫������ҡ����ǡ��д�˽���������Լ�ϲ������Ϸ����������Ʒ�к������һͬ����������Ϸ�����Ӹ����Լ�ϲ������ϷԪ�أ�Ȼ������صȴ���ͬ��ϲ����ЩԪ�ص�������ҵ��ʵ�֮�����̾��������������ij�������Ϸ���������û�֮��Ų���������ɱ��ʲô����������Ա���ͬѧ�ڿμ�����Լ���ϲ�������������������̳�ϰ����Լ���ˮ����Ϸ����������������ڴ�������ʱ������Ϸ�����¸��ֹ����������㿴����Щ���µĹ�����������һЦ��˲�䷢���Լ��ҵ�����֯�����ָо��á�ͬ�����ɡ��ܸ���ĸ��ܲ�������һ����������ද������Ŀ�������������������ô��������������ͬ����ͬ��֮��ͨ��һ�����ţ�һ���������ȷ�ϱ˴����ݵ�Ĭ������Ȼ���������ָо������Ҫ��һ�仰������Ǵ�ž��Ǻܶ���ǰ���Ѿ������������ġ�������ACG��һ�ҡ���չ�Ķ�